新AI『#AppleGPT』テスト、アップルからOpenAIへの挑戦状

KNNポール神田です。

Bloomberg紙のMarkGurman記者によるスクープ。

■(ブルームバーグ): 米アップルは、オープンAIやアルファベット傘下グーグルなどの製品に対抗できる人工知能(AI)ツールの開発をひそかに進めている。事情に詳しい複数の関係者が明らかにした。

■ここ1年にオープンAIのChatGPTやグーグルのBard、マイクロソフトの「Bing AI」が投入され、アップルは足をすくわれている。同社は何年も前からAI機能を製品に導入しているが、テキスト入力に基づき文章や画像、動画を作成できる生成AIツール市場では遅れを取り戻そうとしている。

■同社の主要AI製品である音声アシスタント「Siri」はここ数年停滞している。ただ、スマートフォン「iPhone」の写真や検索の改良など、他の分野ではAIを前進させており、オートコレクト機能のより賢いバージョンが年内にモバイル端末に搭載される見通しだ。

https://news.yahoo.co.jp/articles/c592b863ced3b48e446f78c42828930bcf8f7a2e

AppleがAIアシスタント『Siri(Speech Interpretation and Recognition Interface)』は2010年(今から13年前)にAppleが買収してことによりiOSに組み込まれてきた。AIサービスの『Siri』は、ローンチとしては最も老舗ではあるが、『Siri』の評価はGoogleやAmazonと比較しても低いままだった。

■『Ajax』と呼ばれるフレームワークと『AppleGPT』をApple社内で展開

■NEW:アップル、OpenAIとグーグルに追いつくため、次世代のジェネレーティブAI機能の構築を競う。同社はLLMを構築するための「Ajax」と呼ばれるフレームワークを開発し、「Apple GPT」を社内に展開している。来年の消費者向け製品化を目指している。

これらのtweetを見ていて気になったのが、『LLM(大規模言語モデル)』を構築するために『Ajax』という『フレームワーク』を開発しというくだりだ。

本来、『Ajax』といえば、非同期通信で動的なウェブを構築する『Ajax』をイメージするが、もしかすると、AI時代の『Ajax』をイメージを標榜するならば、ネット非同期でユーザーの情報をセキュアに保ちながら、ユーザーのやり取りしている情報をもとに『LLM』を構築し、それをもとに生成AIを提供するということをイメージできるのではないだろうか?

Appelといえば、プライバシーとセキュリティを売り物にしているといっても過言ではなく、チップセットを含む『ハードウェア』とOSを含む『システム』と『ソフトウェア』と『サービス』において垂直統合の環境で『プライバシー』と『セキュリティ』を重要視している企業だ。

Appleプラットフォームのセキュリティ

https://support.apple.com/ja-jp/guide/security/welcome/web

当然、それらに『生成AI』サービスをOSレベル、いや、チップセットレベルから考えるとするならば、『セキュリティ』で守られた『生成AI』というのは先行するライバルたちとは違った立ち位置でのAI開発が可能となるのではないだろうか?と筆者は考える。

来年2024年の消費者向けのプロダクトがとても楽しみとなった。

BloombergのMarkGurman記者のリポート(English)

BloombergのMarkGurman記者らも、Appleの有償サポートの『AppleCare』などにも『AppleGPT』などは有効だと語る。

Appleにとっても、ユーザーにとっても、自分のデバイスからトラブルシューティングを、AIを使って自己解決できればこれほど有効なことはない。

しかもネット回線が確保できなくても、OSレベルで対話型AIでサポートできるのはまさに理想の姿だ。

■Appleが『AI』を構築する最大の理由は『空間コンピューティング』への入り口だから

保守的にAppleの『AI』を想像すると、すでにいろんなところで、非常に地味にAIが使われている。カメラの補正などは、Google同様にピクセル数に依存しない、人間の目に美しいと感じる補正がハードウェアとソフトウェアのかけあわせのAIで実現している。

『AR』技術においてもそうだ。

Appleの拡張現実機能などは何に使っていいのかわからないほどなのに、開発キットもたくさん用意され力が入れられている。ただ、キラーアプリには成長していない。

しかし、これらはすべてAppleの目指す次世代の『空間コンピューティング(spatial computing)』の一要素であり、『AppleGPT』も、その要素技術としてはとても有用のように考えられる。『VisionPro』のような最初の製品もそれを具現化するための試験的なデバイスである。

2024年は、キーボードを触ることなく、視線で見ているものに対して、口頭で話しかけることによって『生成AI』が音声やテキスト、または映像や画像で返答するという反応を示すということがやっと実現できる時期を迎えそうだ。

WWDC2023の『spatial computing』のセッションでも、サードパーティーへの積極的な開発が促されている。

https://developer.apple.com/wwdc23/topics/spatial-computing/

…とはいえ、これはまだ『空間コンピューティング』の世界の入り口にしか過ぎない…。

しかしながら『生成AI』が『マルチモーダルAI』してくると、いつも行動と共に持っている『iPhone』に『カメラ』や『GPS』が付属し、心拍数を『AppleWATCJ』が計測し、『SNS』や『ブラウザ』に入力したものや出力されたもの、そして『カレンダー』や『リマインダー』といった個人の情報を『LLM』として常に学習してくると『パーソナルアシスタント』としてのAIの強力な情報源の姿がみえてくるようだ。

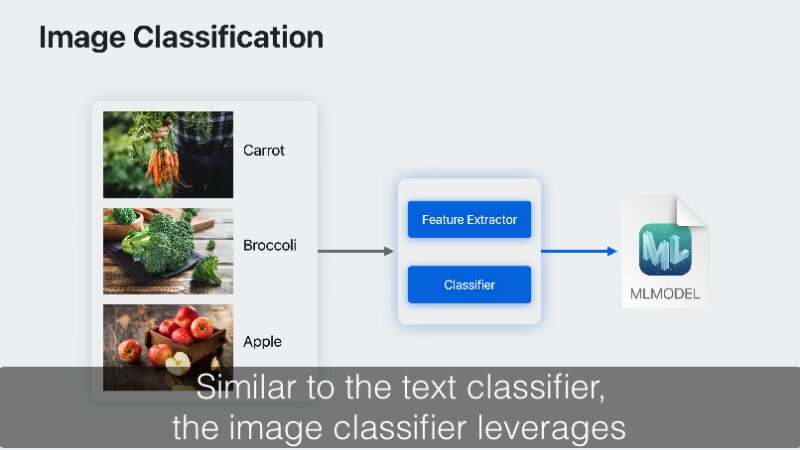

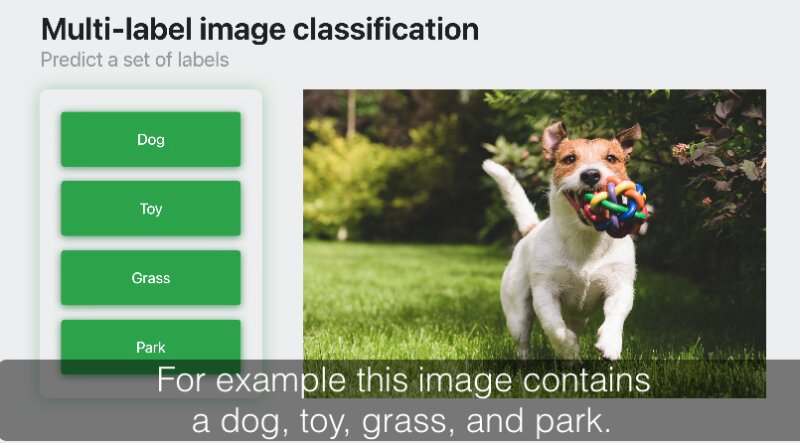

Appleでは直接的に『AI』という言葉を使わずに『ML(マシンラーニング:機械学習)』という言葉で『AI』と同じことを標榜しているのだ。

『ML MODEL(MachineLearning MODEL)』セッション

https://developer.apple.com/videos/play/wwdc2023/10044/

こちらのセッションでは、一枚の写真から数多くの『アノテーション(注釈)』が抽出され、分析される事がわかる。これらの情報を活かして何に使うのかというサードパーティーのアイデアが試されている。

■ジョン・スカリーCEO時代の『ナレッジナビゲイター』までもう少し!

1987年にAppleが提唱した『ナレッジナビゲイター』のコンセプトビデオは、当時のコンピュータの目指す世界に大きな影響を与えた。今年のChatGPTの台頭は、『ナレッジナビゲイター』に大きく近づいたと思う。

『AppleGPT』が登場するならば、今こそ、Appleの描く『アフターAI』の世界観をコンセプトビデオで提示してもらいたいものだ。

毎回、録画による『ジャパネットたかた』スタイルのプレゼンテーションで、自画自賛のプレゼンテーションではなく、ライブで、ロングスパンでのヴィジョンを見せるべきではないだろうか?

■ヴィジョンなき時代のAppleのキーファクターは?

何と言っても、Appleは豊富な資金源と世界中に販売網を持ち、世界で一番安くものを仕入れることができ、最も付加価値をつけて販売できる企業である。

もはや、コンピュータやタブレットや時計やゴーグルを売る会社を離れ、新たな価値を創造し、それを普及させる『インフラ』でもある。ずっと噂をされ続けている『AppleCar』も突然、登場するかもしれない…。

今のAppleに一番、必要なのは、なんのために存在している会社なのかの明確なビジョンなのかもしれない。 それでないとユーザーもヴィジョンに賛同できない。

プライバシーでもセキュリティでもかまわない。Appleが、何の会社かを誰も一言で説明できないことが不安なのだ。

現在のAppleは、このような演繹的で長くてわかりにくいヴィジョンで語られている。

Appleについて

Appleは1984年にマッキントッシュを発表してパーソナルテクノロジーに革命を起こしました。今日、AppleはiPhone、iPad、Mac、Apple Watch、Apple TVなどのイノベーションで世界をリードしています。Appleの4つのソフトウェアプラットフォーム(iOS、macOS、watchOS、およびtvOS)は、すべてのAppleデバイスにわたってシームレスなエクスペリエンスを提供し、App Store、Apple Music、Apple Pay、およびiCloudなどの画期的なサービスを人々に提供します。Appleの10万人以上の従業員は、地球上で最高の製品を作り、私たちが見つけたよりも良い世界に導いていきます。

https://www.apple.com/jp/newsroom/2023/06/introducing-apple-vision-pro/

現在のAppleのサイトを見ても、会社に関する情報が稀有である。巨大なApple製品専門の通販サイトにしかすぎない…。

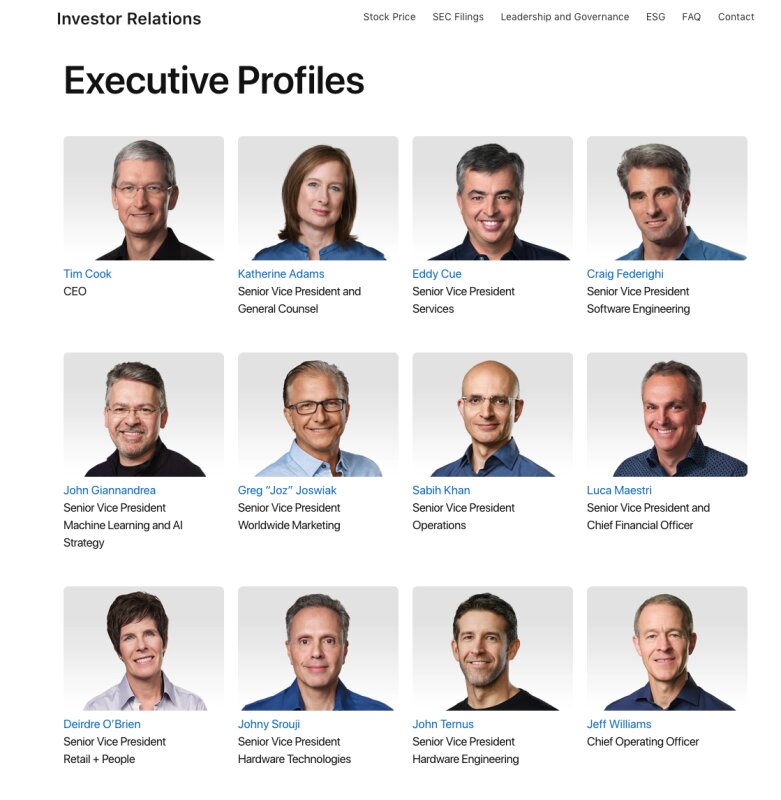

Appleの企業としてのスタンスを見るためには、投資家向けのサイトを見るしかないようだ…。

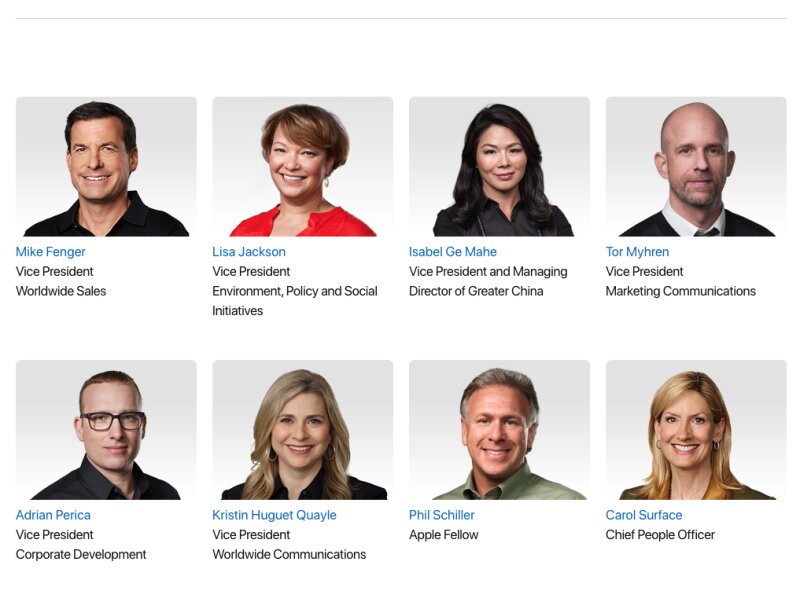

そしてAppleの顔の見えるページはここだけしかない…。

https://investor.apple.com/leadership-and-governance/default.aspx