OpenAIの特許を分析する(4):DALL-E2の基本設計特許

OpenAIがOpenAI Opco LLC名義で出願した特許の解説シリーズの4回目です。今回は、US11922550B1"Systems and methods for hierarchical text-conditional image generation"(階層型テキスト条件付きイメージ生成のシステムと方法)です。出願日は2023年3月30日、登録日は2024年3月5日(優先審査請求)です。米国分割出願、および、PCT出願の存在が確認されていますが、出願公開日前なので内容は不明です。米国外での出願は確認できていません(出願日からまだ1.5年経っていませんので、先に特許登録されていない限り公開されることはありません)。

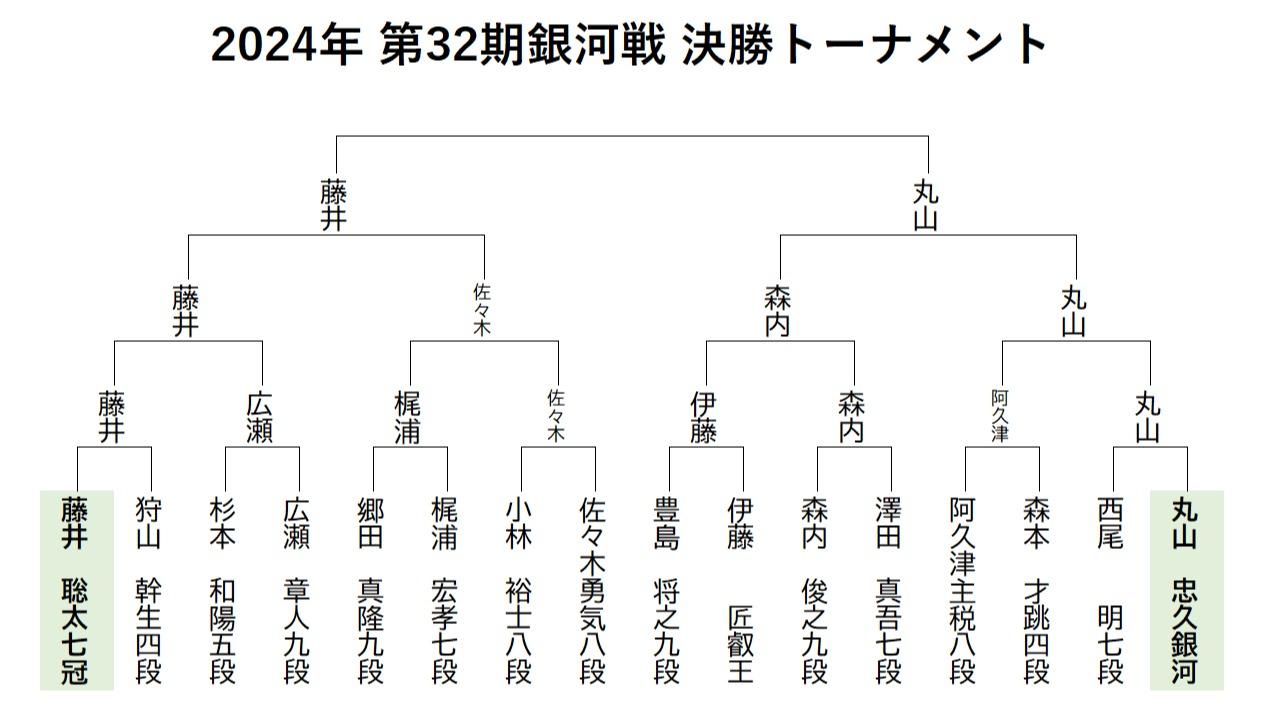

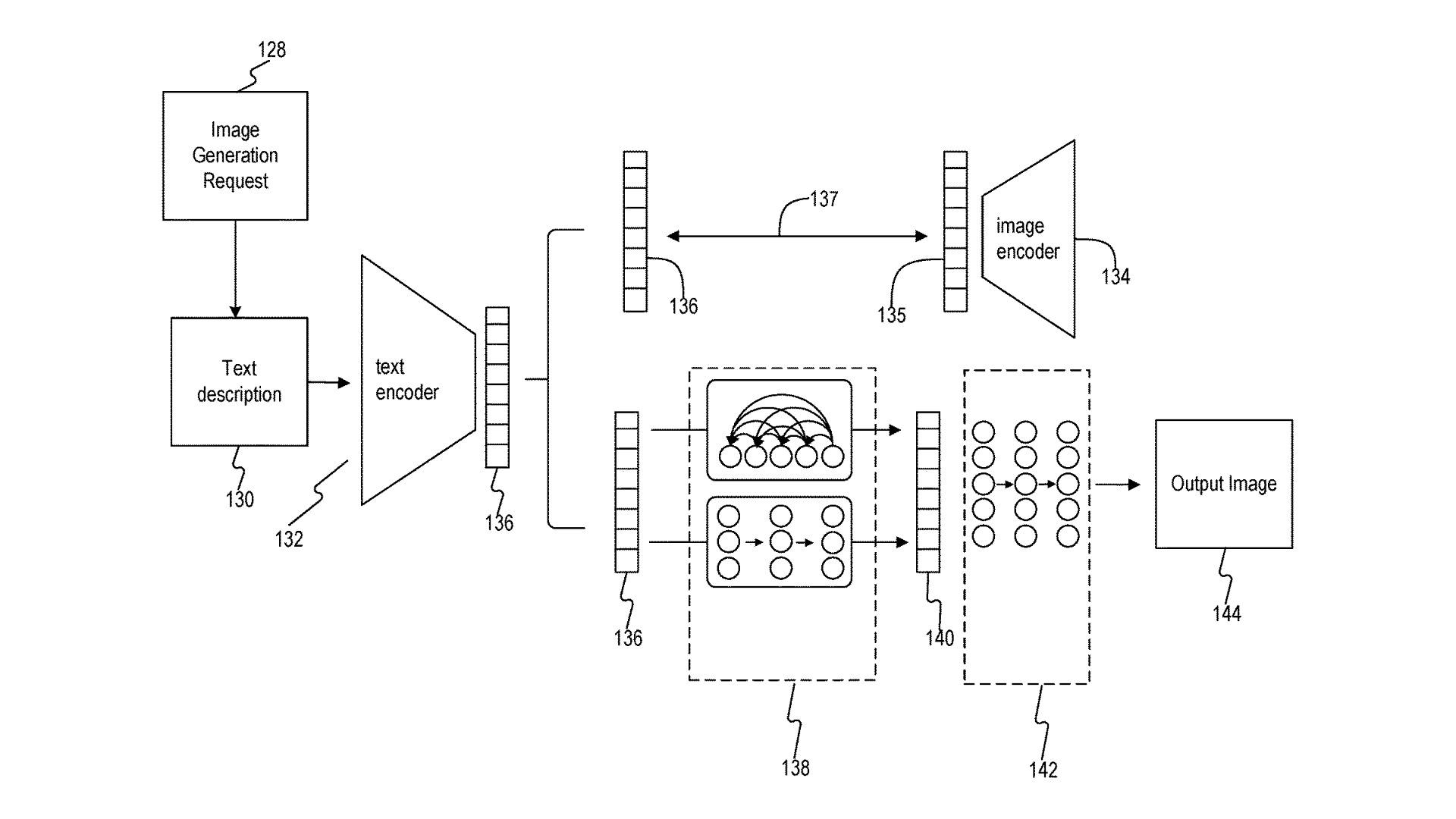

この特許明細書は、論文”Hierarchical Text-Conditional Image Generation with CLIP Latents”がベースになっていますが、この論文は、OpneAIの画像生成AIであるDALL-E2の実質的な発表論文です(論文中にも明細書にもDALL-E2という言葉は出てきませんが)。特許明細書もDALL-E2の設計をほぼそのまま反映しています。たとえば、タイトル画像で引用した明細書の図面は論文中の図と同じであり、DALL-E2のアーキテクチャ説明で出てくる図とも同じです。

なわち、DALL-E2のデッドコピーサービスを作って商用化すると、この特許権に抵触する可能性が生じます。なお、特許権は「業として」の使用にしか及びませんので、実験的に開発・使用するだけでは特許権を侵害することは原則的にありません。

なお、OpenAIに限ったことではないのですが、米国(および日本)では発明者自身による発表から1年以内であれば新規性の問題なしに特許出願可能です。そして、出願公開は出願から1.5年後なので、他人が、論文を見て、オープンな技術であろうという仮定の元にそのアイデアを商用実装したりすると、2.5年後に実は特許出願されていたことがわかるといった事態があり得ますので注意が必要です。

この特許のポイントは、画像生成AIにおいて、①CLIP(Contrastive Language–Image Pre-training)というimage-to-text技術を使用すること、および、②CLIPで事前学習させたモデルと拡散モデルの2段階のモデルで画像を生成する点にあります。

画像生成AIでは、当然ながら画像データでモデルを訓練する必要がありますが、ラベル付き画像データ(たとえば、犬の画像に”dog”とラベルが付いているもの)を大量に準備するのはきわめて手間がかかります。CLIPでは、ラベル付きではなく、キャプション(説明テキスト)付きの画像(たとえば、犬の画像に”a small dog is walking in the park”とラベルが付いているもの)を教師データとして使用します。これならばインターネット上に膨大なデータが存在します。

そして、CLIPの仕組みで訓練されたニューラルネットにより逆処理を行うことで(特許明細書には書いてないですがunCLIPと呼ばれる処理です)テキストから画像を生成できるようにする(実際の生成は拡散モデルによって行う)というのがこの特許発明の1番目のポイントです。

また、2段階モデルの1段目はunCLIP処理により得られた事前知識(prior)であり、2段目は拡散モデルから成ります。これにより、同じプロンプトから、様々なバリーエションの画像が生成可能になります。これが、2番目のポイントです。

クレーム1の内容は以下のとおりです。

この記事は有料です。

栗原潔のIT特許分析レポートのバックナンバーをお申し込みください。

栗原潔のIT特許分析レポートのバックナンバー 2024年8月

税込880円(記事1本)

2024年8月号の有料記事一覧

※すでに購入済みの方はログインしてください。