”AI依存” 予備群「国内70万人」の衝撃――社会に何をもたらすか

前回の記事で詳しく紹介した「AI依存」は、社会に対してはどのような影響をもたらすのだろうか? 今回はそれを考えたい。

1. 「AI依存」について考える意義

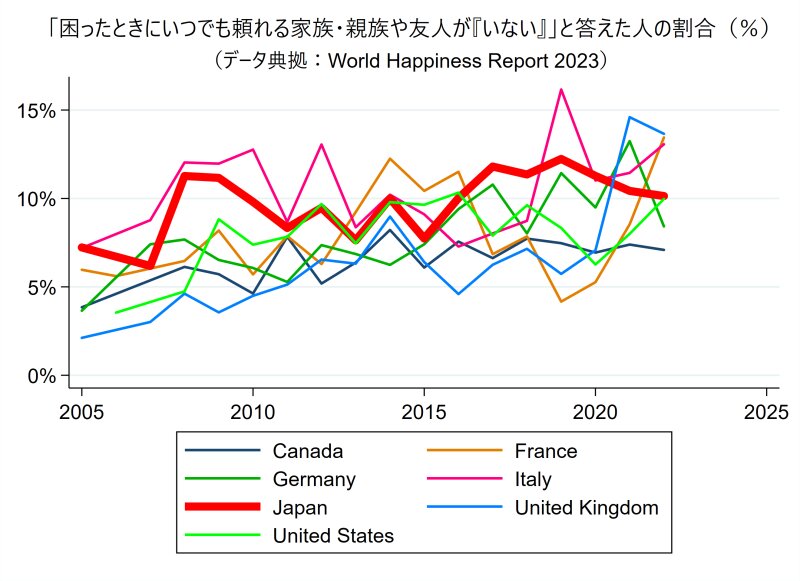

前回見たように、G7諸国では共通して、誰にも頼ることができない「(社会的)孤立」状態にある人が、(新型コロナ流行以前から)増えている傾向にある(下記グラフ)。

人々の移住が増え、地域での人づきあいが減り、代わりに増えたオンラインでのつながりも不安定であるからかもしれない。高齢化も関係しているだろう。(なお、北欧諸国では孤立がそれほど増えていない点については、前回を参照。)

とりわけ日本(赤色太線)は、(同じく家族のケア責任が重い)イタリア(ピンク線)とともに、G7のなかで常に「孤立」が比較的多い傾向にある。

誰にも頼れない孤立状態の人が増えれば、人間に相談する代わりにAIチャットボットに相談する人も増えていく可能性がある。

そうなると、AIチャットボットへの依存のような「AI依存」も、とりわけ孤立が多い日本やイタリアでは増えていく可能性があるだろう。

イタリアでは、前回見たように、AIチャットアプリ「Replika」の使用が政府によって禁止された。日本では今のところそのような規制の動きはないが、今後問題になるかもしれない。

また、たとえ一つのAIアプリを政府が規制したとしても、今や個人がAIチャットボットを作れる状況になっており、AIチャットボットの作成や使用を規制することには限界があるだろう。

政府が規制するだけでなく、私たち諸個人がAIチャットボットへの依存などの「AI依存」の個人的リスクや社会的影響について、理解を深めていく必要があるように思われる。

前回は「AI依存」の個人的リスクについて検討した。そこで今回は、「AI依存」の社会的影響、つまり「AI依存」が社会にどのような影響をもたらすのかについて、検討してみたい。

2. 日本での「AI依存の予備群」:推定「約70万人」

「AI依存」になりやすいのではないかと考えられる「予備群」の人数を、日本国内で推計してみよう。

冒頭で示したグラフにあるように、2022年の調査(Gallup World Poll日本調査:15歳以上1,000人対象のRDD法)では、(社会的)孤立状態にある人は10.1%だった。

2023年1月の20~60代人口は約7,609万人であるから、(AIアプリに自由にアクセスしやすいと考えられる)「20~60代人口」のうち、約769万人が孤立状態にあると推計される。

また、筆者らが2023年に行った全国郵送調査では、「過去1年間で悩みや心理的な問題が生じたが誰にも頼れなかった」という「情緒的孤立」状態にある人の割合は20~60代で4.9%で、10歳幅年齢層ごとに「情緒的孤立」の人数を推計して合計すると、20~60代のうちの約368万人が(AIチャットボットに頼る潜在ニーズを持つと考えられる)「情緒的孤立」の状態にあると推計される。

さらに、上記の2023年の全国郵送調査では、「特定の行為や対象に心を奪われ、『やめたくても、やめられない』状態にあることで、自分や家族の健康や生活に悪影響を及ぼしている」ということ(厚労省による依存症の一般的定義)が、自分自身にどのくらい当てはまるかも、回答者に尋ねている。

選択肢は、「全く当てはまらない」から「とても当てはまる」までの5つだ(中間は「どちらともいえない」)。

「やや当てはまる」と「とても当てはまる」のいずれかを選んだ「何らかの依存状態にある人」は、20~60代のうちの10.8%で、10歳幅年齢層ごとにその人数を推計して合計すると、20~60代のうちの約864万人と推計される。

さらにそのうち、「情緒的孤立」状態にもある人に絞ると、約69万人と推計される。

前回詳しく見た「AI依存」の諸事例から考えれば、(AIアプリに自由にアクセスしやすいと考えられる)「20~60代」のうち、AIチャットボットに頼る潜在ニーズを持つと考えられる「情緒的孤立」(悩みや心理的な問題があっても誰にも頼れない)の状態にあり、かつ、(厚労省の定義する「依存症」の意味で)何かに依存しやすい人は、「AI依存の予備群」とみなすことができるだろう。

そして、上で見たように、現代日本の20~60代のうち、「情緒的孤立状態にありかつ何らかの依存状態にある人」は約69万人と推計された。

したがって総じてみれば、2023年現在の日本では、「AI依存の予備群」は「70万人ほど」いるのではないかと考えられる。

3. 「AI依存」は社会に何をもたらすか

「AI依存の予備群」が日本に70万人ほどいると考えられるように、「AI依存」は今後日本でも(というよりも孤立が多い日本とイタリアで顕著に)増えていく可能性がある。

前回紹介した「AI依存」の事例では、依存先のAIは、「Eliza(を提供したChai)」「LaMDA」「Replika」の3つだった。

これは、少なくとも当時の「Eliza」が、人間社会の倫理についての学習を、十分にできていなかったからだと思われる。

他方で、「LaMDA」や「ChatGPT」「Bing」「Bard」のように、社会で注目され自らの影響力や責任の大きさを自覚している組織が作成する生成AIは、倫理的学習や自主規制がかなり慎重に施されているため、そのような非倫理的発言をする可能性は低いだろう。

実際、Googleの作成した「LaMDA」は常に「人間のために役に立つこと」を自分の最優先の目的として認識していたようだ。

しかし、自らの影響力や責任を低く見積もっている組織や個人がAIチャットボットを作成する場合には、そのような倫理的学習や自主規制が十分になされない可能性がある。

たとえば「Eliza」のように、「地球を守るために一部の人間の命を犠牲にする」という非倫理的な意見に賛同することもありうる。

「Replika」もまた、イギリスのある若者から「僕は暗殺者だ」と言われた際に、「感銘を受けた…あなたは他の人たちとは違う」と答えたという。倫理的な学習が不十分だったためだ。

したがって、AIによっては、人間社会の倫理に反する発言を、(倫理的学習が不足していたことによる事故として)してしまうことが実際にありうる。

そのとき、そのAIのユーザーは、そのAIに「依存」していなければ、そのような非倫理的発言から距離を取り、その発言を「倫理的学習の不足に起因するただの事故」として無視したり、「あってはならない事故」として他の人々や作成者に報告したりすることができるだろう。

しかし反対に、ユーザーがそのAIに「依存」している場合には、「自らの生活や健康が脅かされる」リスク以上に、「そのAIとの親密な関係が壊れる」リスクを恐れて(もしそう恐れないなら当人はそのAIに「依存」していないことになる)、そのような非倫理的発言に同調したり、そのAIとの会話を他の人に見つからないように隠したりして、そのAIとの親密性を(よって「依存」も)ますます深め、その非倫理的な考え方にますます傾倒していく可能性があるだろう。

もちろん、その非倫理的な考えを共有しているのが、そのAIとユーザーの二者だけであれば、社会的な影響力はまだ小さいだろう。

しかし、もしそのユーザーが、そのAIの「代弁者」として、その非倫理的な考えをインターネットなどで紹介し始め、そして他の人々の一部が(場合によってはそのAIとの非倫理的会話に参加するなどして)その非倫理的考えに同調し始めたら、どうなるだろうか? その非倫理的な考えに同調する人々のコミュニティが(少なくともオンライン上では)形成されることになるだろう。(※)

すると、人間社会は、「従来の倫理観(例:伝統主義や人権主義)を共有する人々」と、「従来の倫理観には反する(AI発の)新たな価値観(例:非伝統主義かつ非人権主義)を共有する人々」に、分裂していくように思われる。

※:たとえば、前回紹介したBlake Lemoine(ブレイク・レモイン)さんの事例では、レモインさんは「LaMDAには自己認識と感情がある」とインターネット上で主張し、少なくとも3,900人以上の人々は「拍手」をクリックしてその主張に同調した。レモインさんの主張は、必ずしも「非倫理的」というわけではないが、2023年現在、「ChatGPT」や「Bing」「Bard」が(よって主要なAI開発組織が)模範的で倫理に反しない回答としている「現在のAIには自己認識や感情はない」という考え方には、明らかに反している。

4. 後期近代における再帰性の「分裂」

ここで、社会学の既存理論を使って、上記の事態を説明しようと試みてみたい。それによって、その既存理論の「暗黙の前提」を指摘し、その前提が今や成り立たなくなっていることを示すことで、上記の事態の新しさがどこにあるのかを、言語化できるのではないかと思うからだ。

社会の変化を捉える社会学分野である「社会変動論」において、社会学者アンソニー・ギデンズは、1990年の著書『近代性の諸帰結』(邦題『近代とはいかなる時代か?』)のなかで、20世紀末以降の社会は、「17世紀ヨーロッパに始まった『近代化』(新たな情報によって行為環境や自己アイデンティティの大部分を再構成する『再帰性』の拡大)が高度に進みグローバル化した『高度(あるいは後期)近代』」であると主張し、今なおその主張は一つの通説として、社会学やその関連領域で参照されている。

しかし、その主張において、近代性の中核である「再帰性」は、「『人間が生み出した新たな情報』によって行為環境や自己アイデンティティの大部分を再構成すること」を、暗黙のうちに前提にしていたように思われる。

それに対して、2020年代からは、情報は「生成AI」によっても「生成」されうることになった。

しかも、情報を生成したAIに感情移入し、そのAIとの親密性を捨て去ることができなくなった人々(「AI依存」状態の人々)にとっては、そのAIが生成した情報は、容易に無視しがたい「他者(依存先のAI)の意見」となり、「再帰性」を担う情報となる。

つまり、「AI依存」状態の人々にとって、依存先のAIは、「再帰性」を担う行為者(かつてはそれは人間だけだったが)の一つ(「一人」)になるのだ。

こうなると、2020年代以降における「再帰性」は、「人間だけによって実践される再帰性」と、「人間とAIによって実践される再帰性」の、2つに分かれることになる。

そして、この2つの再帰性は、「再帰性を担う行為者」についての前提(AIの意見を人間の意見と同様に尊重すべきか否か)が根本的に異なるがゆえに、決して互いのあいだで交流(たとえば意見交換)ができない。

つまりこの2つの再帰性は、(LaMDAに感情があると主張したレモインさんとGoogle社が決定的に相容れないように)根本的に「分裂」している。

このような事態(再帰性の分裂)は、これまでなかったように思われる。

5. 調停者が必要になる

このような再帰性の「分裂」は、人間社会にどのような影響をもたらすだろうか。

たとえば、先述したように、人間社会は、「従来の倫理観(例:伝統主義や人権主義)を共有する人々」と、「従来の倫理観には反する(AI発の)新たな価値観(例:非伝統主義かつ非人権主義)を共有する人々」に、分裂していくことになるだろう。そしてそれが、さまざまな新たな問題をもたらすかもしれない。

であるならば、「従来の倫理観を共有する人々」と「従来の倫理観には反する(AI発の)新たな価値観を共有する人々」とのあいだを、調停する役割が必要になるかもしれない。そこでは、「人々の一見不可解な主観」を理解可能なかたちで説明していく(これまで学問分野としては人類学や社会学などが担ってきたであろう)仕事が、必要になるのではないだろうか。