何を「根拠」に診断しているのかわからない「医療用AI」の問題とは、東北大学の研究

法医学の分野では死因の特定が重要だ。だが、溺死の場合は診断するのが難しいため、死因が溺死かどうかをAI(人工知能)がCT画像で診断する方法が検討されてきた。今回、東北大学の研究グループが、AIによる画像診断の限界を溺死の診断を用いて評価し、医療用AIの課題を明らかにした。

溺死の診断の難しさ

水中から発見された死体については、死亡後に水中に転落した場合や絞殺などの他の手段で殺害された後に水中に遺棄される場合などがあり、その死因について診断することは事故か事件か、事件の捜査などに影響するため、重要な検査となっている。

だが、これまで法医学の分野では、死体の解剖の所見だけでは死因が溺死かそうでないかを診断することが困難であり、CT画像だけでも確実に区別することはできないと指摘されていた(※1)。死後では造影剤を使えないため、CT画像による検査は溺死者の既往症や組織の損傷など、簡単な診断だけに限られ、CT画像を正確に読影できる医師や技術者も少ないからだ。

溺死かどうかは、口や鼻、器官や肺などの呼吸器の状態を解剖によって調べ、死後CT画像で呼吸器や胃の内容物を検査(Wydler徴候)し、臓器からプランクトンや藻、砂泥などを検出するなどして診断する。他の死因が考えられるため、それぞれの検査だけでは死因が溺死かどうかを特定することは困難とされてもいる。

そのため、医学的な検査のほか、発見された時の死体や現場の状況などを総合的に考慮し、消去法で検査していく。また、最近では、補助的な手段として死後のCT画像をAIのディープラーニング(深層学習)を使うことで死因を特定する方法が普及し始めている(※2)。

医療分野で進むAI活用

医療分野でのAIを活用した技術は、特に画像診断で広まってきている。2019年頃から大腸の内視鏡画像をAIで解析するソフトウェアが販売され、脳のMRI画像をディープラーニングを使った画像解析ソフトウェアが、また新型コロナ(COVID-19)によって肺のCT画像の診断を支援するAIが提供されるなどしてきた。

東北大学大学院医学系研究科の研究グループ(※3)は、実際の医療現場でディープラーニングを使った診断にどれくらい精度があるのか、これまで十分な評価がなかったとし、ディープラーニングが溺死のCT画像で注目した診断箇所の医学的な妥当性を詳細に解析し、その結果を専門学術誌で発表した(※4)。

AIで使われるディープラーニングでは、画像処理のために高性能なGPU(Graphic Processing Unit)とニューラルネットを使い、画像のビッグデータを学習データとして計算をする。

だが、このニューラルネットでの処理の過程がブラックボックスになる。つまり、どうやって解答を出しているのか、そのプロセスがわからないという問題が起きる(※5)。

医療分野でのAI活用では、ディープラーニングが不適切な考え方(根拠)で導き出した解答が予想外の誤診の原因になり、あるいは異なる性質を持つ症例画像を学習した場合、ディープラーニングの性能の劣化につながる危険性があると議論されてきた(※6)。

AIの診断とヒトの診断を比較する

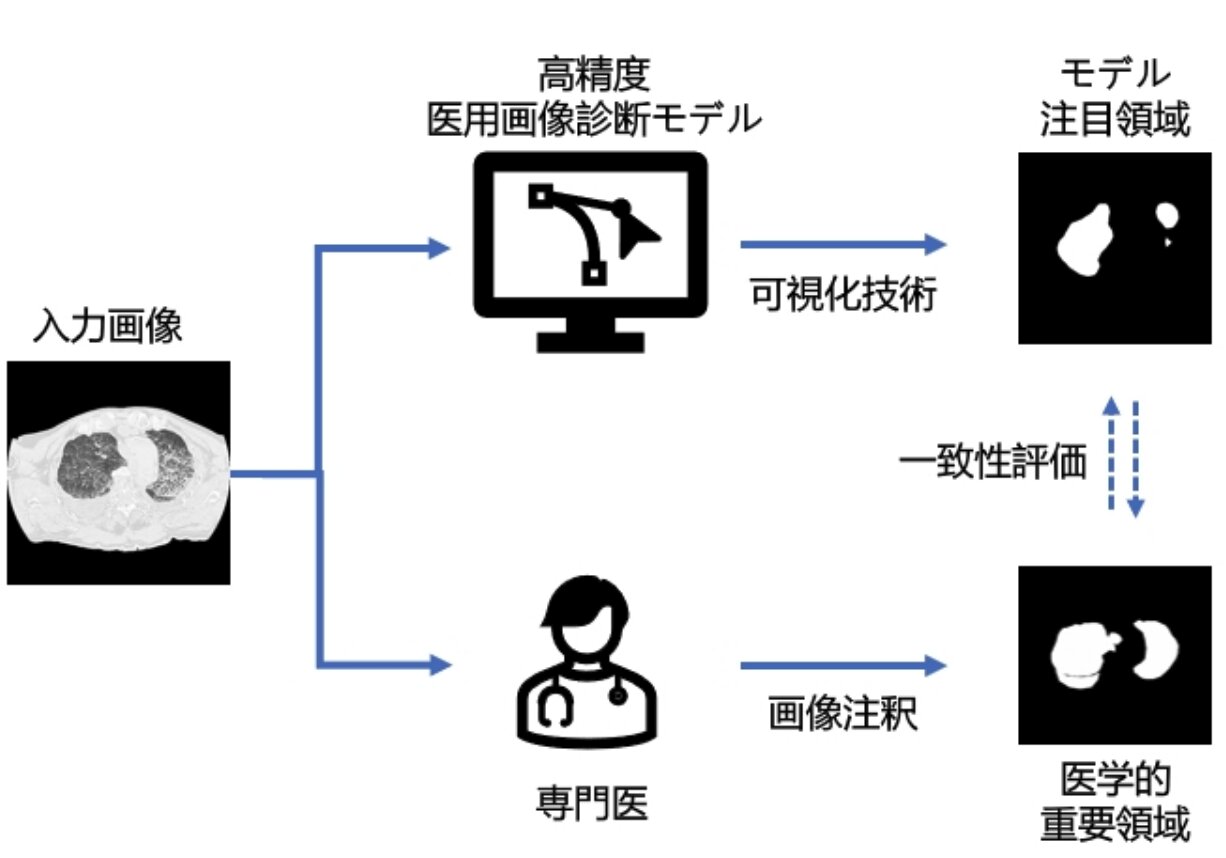

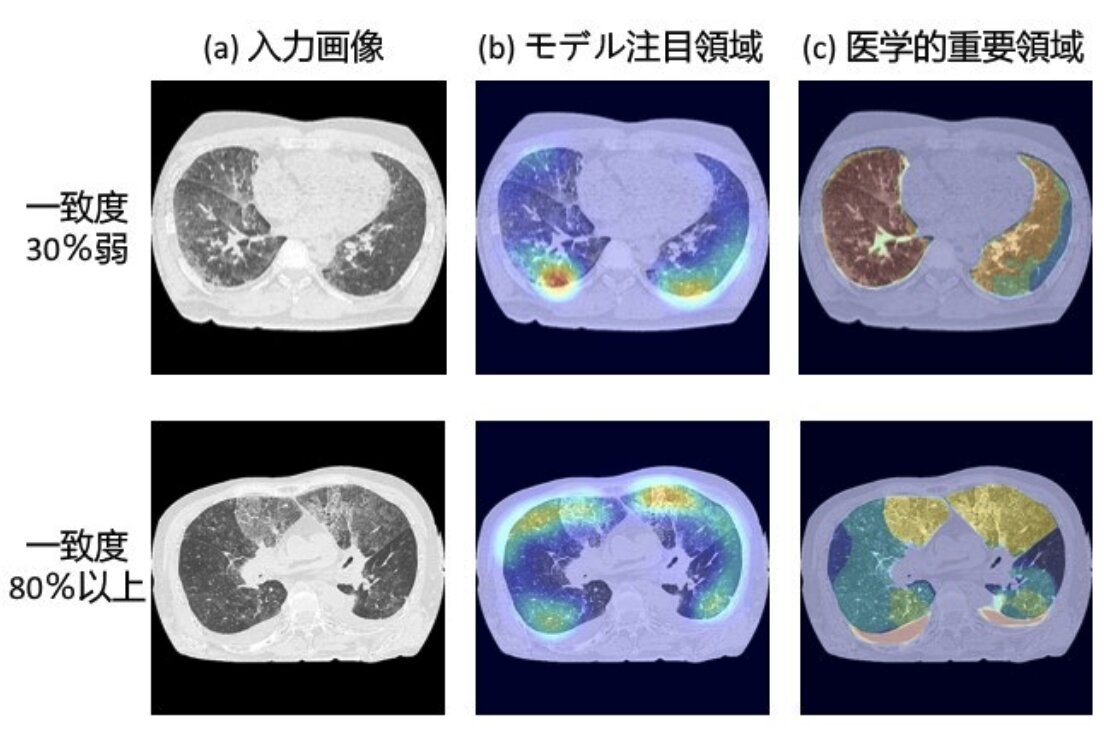

同研究グループは、ディープラーニングにおけるブラックボックスの問題を検証するため、ディープラーニングが画像のどこの部分に注目して計算していたのかを可視化する技術を使い、溺死を診断した先行研究でのディープラーニングの注目領域を特定し、一方で4人の放射線診断医が同じ溺死者のCT画像に注釈(アノテーション)を入れた画像領域を比較して検討した。

その結果、ディープラーニングによる注目領域は、最小で30%しか医学的な画像領域と一致しておらず、80%程度の一致でも重要視する画像内での位置が異なっているなどした。また、よりパフォーマンスの高いディープラーニングのほうが、不一致するケースが多かったという。

使用した先行研究の画像診断では、90%以上の正答率で溺死を診断できる可能性を示唆しているが、同研究グループは、正答していることとそれが医学的に妥当かどうかは別であり、ディープラーニングによる診断が不適切な考え方(根拠)によるものである場合、予想外の結果が生じる危険性があると指摘している。

もちろん、あらゆる分野でAIの活用は不可逆的で後戻りできない。医療分野でもそれは同じだ。

だが、ディープラーニングは、そのプロセスがブラックボックスであるため、薬事承認が難しいとされてきた。例えば、AIからある診断が出た場合、患者にその診断がなぜ出たのか、どのように出たのかを説明できない危険性がある。

同研究グループは、ディープラーニングの学習法の計算モデルをヒトの専門知識に基づく意思決定の方法へ近づけることが必要とし、ヒトによる注釈を慎重に吟味しつつ積極的に活用し、それとAIが出した結果を照らし合わせ、そのプロセスを記録しておくことが重要と述べている。また、クラウドの活用などにより、多くの専門家による注釈の蓄積がディープラーニングの学習法へ影響し、画像診断の品質をより高めることができるだろうと考えている。

※1:Astrid J. L. Van Hoyweghen, et al., "" International Journal of Legal Medicine, Vol.129, 159-164, 17, July, 2014

※2:Terumasa Ogawara, et al., "Diagnosing Drowning in Postmortem CT Images Using Artificial Intelligence" Tohoku University Medical Press, VOl.259, 65-75, 17, November, 2022

※3:東北大学大学院医学系研究科医用画像工学分野の曾昱雯(ソウ・イブン)助教、張暁勇(チョウ・ギョウユウ)非常勤講師(現所属:仙台高等専門学校総合工学科)、本間経康(ほんま・のりやす)教授ら

※4:Yuwen Zeng, et al., "Inconsistency between Human Observation and Deep Learning Models: Assessing Validity of Postmortem Computed Tomography Diagnosis of Drowning" Journal of Imaging Informatics in Medicine, doi.org/10.1007/s10278-024-00974-6, 9, February, 2024※5:Cynthia Rudin, "Stop explaining black box machine learning models for high stakes decisions and use interpretable models instead" nature machine intelligence, 1, 206-215, 13, May, 2019

※6-1:Alex John London, "Artificial Intelligence and Black-Box Medical Decisions: Accuracy versus Explainability" The Hastings Center Report, 21, February, 2019

※6-2:Thomas P. Quinn, et al., "The three ghosts of medical AI: Can the black-box present deliver?" Artificial Intelligence in Medicine, Vol.124, 102158, February, 2022