OpenAIの特許を分析する(2)

OpenAIがOpenAI Opco LLC名義で出願した特許の解説シリーズの2回目です。今回は、US11887367B1 (”Using machine learning to train and use a model to perform automatic interface actions based on video and input datasets”) です。

出願日は2023年4月19日、登録日は2014年1月30日です(優先審査(Track One)請求)。分割出願が係属中で残っていますが、出願公開日前なので内容不明です。米国以外での出願は今のところ不明ですが、PCT出願は確認できていません。

この特許は、OpenAIが考案したVPT(Video PreTraining)という動画を教師データにしたニューラルネットの学習方法に関するものです。Soraのようにテキストを入力して動画を生成するのではなく、動画をベースにユーザー・アクション(典型的にはマウスとキーボードによるGUIの操作)を生成することを目的としてます。

明細書の内容が抽象的でちょっとわかりにくいのですが、"Video PreTraining (VPT): Learning to Act by Watching Unlabeled Online Videos"というOpenAIの研究者の論文が引用されており、この論文の方を先に読んでおくと、何をやろうとしている特許発明なのかがわかりやすくなります。

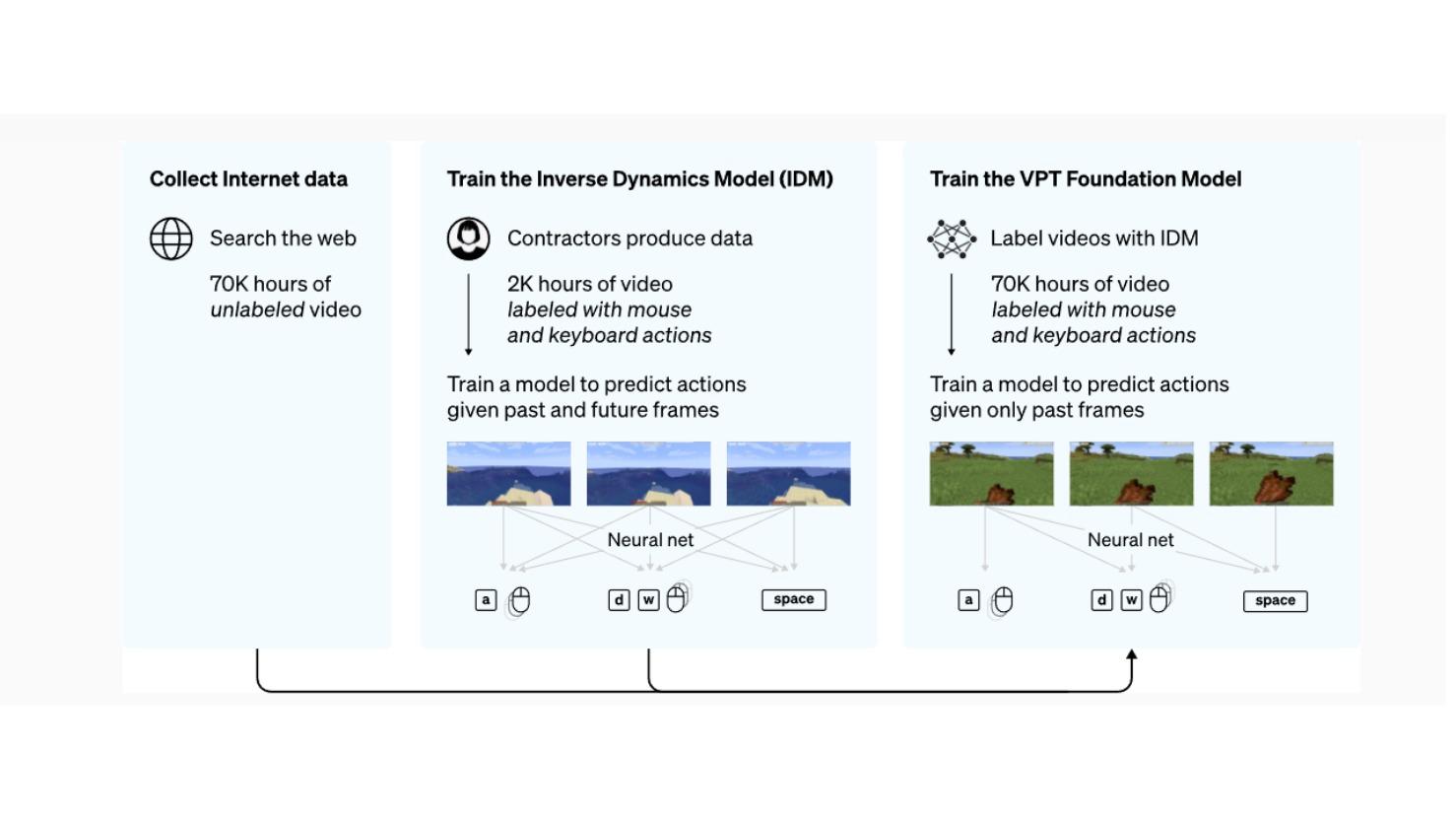

さらに、OpenAIが関連プレスリリースも出しており、これを読むとさらにわかりやすいです。ネット上に大量にあるマインクラフトのプレイ動画、および、人間の契約社員によるラベル付きの少量のプレイ動画を組み合わせて教師データとして訓練することで、ダイヤモンド採掘ツールの作成(人間であれば通常20分くらいかかる24,000アクションを要する作業)を行わせることに成功したとのことです。大量のラベルなし動画データから効率的に学習できるのがポイントです。

この特許発明のポイントは、ユーザー・アクション(典型的にはGUIの操作)を学習させるために、①ラベルなし教師データから疑似ラベルあり教師データを生成する、②この生成プロセスにおいてIDM(inverse dynamics model)(逆動力学モデル)を利用する点です。ここで、「ラベル」とはその動画フレームに対応するマウスやキーボードの操作です。IDMとは、ロボット工学などで一般的ですが、目標とする動作を与えて、それに必要な入力を逆算で予測するモデル(たとえば、コップを掴むという動作を達成するために必要な各関節の動きやトルクを予測)です。こうして生成された疑似ラベル付き動画データにより基盤モデルを訓練し、さらに、強化学習により、性能を向上できます。人間のような知能を持った(かのように見える)RPAのオバケのようなシステムが可能になるかもしれません。

この特許出願ですが、出願時からクレームの限定はかかっていますが、実質的に上記論文に記載されたVPTの考え方をほぼそのままで特許化できているのではと思います。もし、VPT的なシステムを商用化したい場合には気にしておいた方が良い特許でしょう。

この記事は有料です。

栗原潔のIT特許分析レポートのバックナンバーをお申し込みください。

栗原潔のIT特許分析レポートのバックナンバー 2024年6月

税込880円(記事1本)

2024年6月号の有料記事一覧

※すでに購入済みの方はログインしてください。