Wikipediaを「AI生成のデマ」が襲う、その掃除の方法とは?

ウィキペディアに「AI生成のデマ」が、襲ってかかっている――。

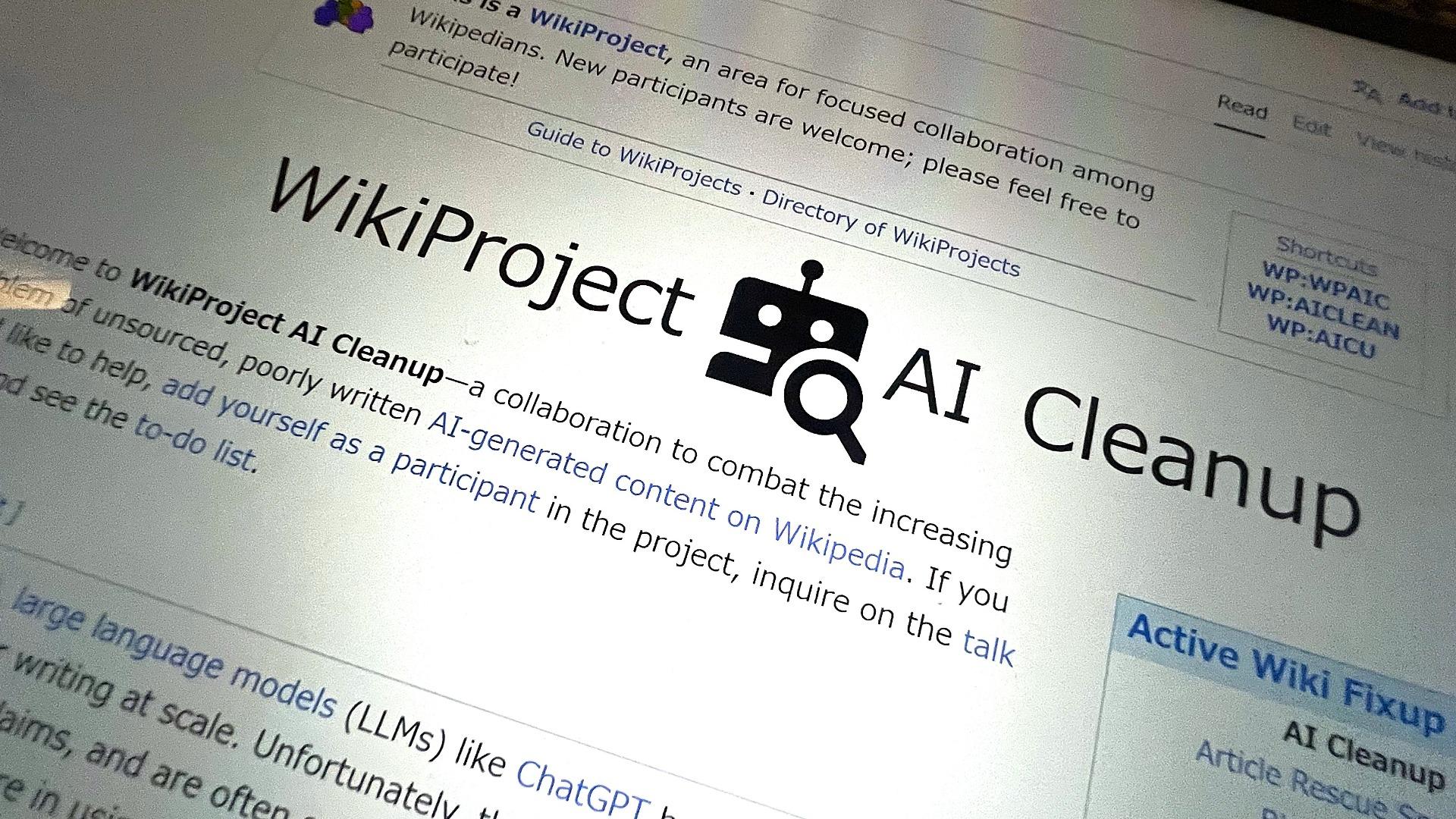

クラウドソースのオンライン百科事典「ウィキペディア」のボランティア編集者たちが、生成AIを使った虚偽情報などの低品質コンテンツを排除する「ウィキプロジェクトAIクリーンアップ」に取り組んでいる。

テクノロジーニュース「404メディア」が10月9日付の記事で報じている。

これまでにも「ウィキペディア」を舞台に、様々な虚偽情報の書き込みが行われ、そのまま主要メディアに掲載されてしまったケースもある。

そこに人間と見分けのつかない生成AIを使った虚偽情報も押し寄せているのだという。

英語版だけで700万件近い記事を抱えるウィキペディアの、ゴミ掃除の方法とは?

●「低品質のAI生成コンテンツと闘う」

(ウィキペディアの記事の中に)一般的なAIの決まり文句を発見したことで、生成された記事の最もひどい例を即座に見つけることができた。すぐに、私たちが発見したこととテクニックをまとめる組織的なプロジェクトを作り上げたいと思った。

プロジェクトの創設者の1人、イリヤス・レブル氏は、「404メディア」のエマニュエル・マイバーグ氏のインタビューに、そう答えている。

編集者たちが手がかりにしている「AIの決まり文句」とは、「AI言語モデルとして」「最新の知識更新時点で」といった、生成AIがプロンプト(指示文)に対して、免責表現として使うフレーズとして知られるものだ。

※参照:1週間で記事8,600本、「AIコンテンツ工場」がネット広告費を飲み込む実態とは?(06/29/2023 新聞紙学的)

その1つに挙げられているのが、米イリノイ州の「チェスター精神保健センター」に関するウィキペディアの記事だ。

この記事に対する2023年11月25日の書き込みでは、「2022年1月の最新の知識更新時点では、チェスター精神保健センターの現状や関連する動向について、具体的な情報を持っていません」という、「AIの決まり文句」が入り込んでいた。

さらに、最も印象的な事例として挙げられているのが、オスマン帝国の要塞「アンベルリシハール」についての記事だ。

アンベルリシハールはトルコのトラブゾンにあるオスマン帝国の要塞。1466年、メフメト征服王によって、アク・コユンル朝(白羊朝トルクメン)に対する防衛のために建設された。

その6世紀にわたる歴史をたどった2,000語を超す重厚な記事にもかかわらず、この要塞は存在せず、参考文献も存在しないものだという。

この記事は、全文がチャットGPTを使って書かれていたという。公開されてすぐの2023年1月2日に書き込まれ、11カ月にわたって公開された後、12月4日に削除された。

この直後、「ウィキプロジェクトAIクリーンアップ」が立ち上げられたのだという。

現時点で75人の編集者がプロジェクトに参加している。

●繰り返される虚偽掲載と排除

ウィキペディアがスタートしたのは2001年1月。以来23年で、ウィキペディアの記事は英語版だけで689万5,363件、46億語超(10月13日現在)に上り、月間1万4,000件のペースで増加を続けている。

その中には様々な虚偽情報が入り込む。ボランティアの編集者らによる検証とデマ排除の取り組みは、生成AIの普及以前から続いてきた。

そして、編集者の目をすり抜け、掲載を続けてきた虚偽情報も少なくない。「ウィキペディアのデマ」というページにまとめられている。

実在しない英国の革命家「ドノバン・スラックス」に関する記事は、ウィキペディアは始まって3年後の2004年11月に掲載され、2024年2月に削除されるまで、20年近くにわたって掲載されていた。映画の架空のキャラクターだという。

2009年4月には、映画『アラビアのロレンス』などで米アカデミー賞作曲賞を3度受賞した作曲家、モーリス・ジャール氏死去の報道で、ガーディアンやインディペンデント、BBCのウェブサイトなどがウィキペディアに掲載されていた「生前の発言」を掲載した騒動があった。

これは、ユニバーシティ・カレッジ・ダブリンの大学生が書き込んだ虚偽情報を、メディアが確認をせずに掲載したものだった。

生成AIの普及は、その使いやすさでユーザーの参入ハードルを下げ、高度な生成機能で人間がつくったコンテンツとの見極めのハードルを上げ、コンテンツ作成の規模を拡大させた。

その結果、ソーシャルメディアの投稿やコマースサイトの商品レビューなどで、虚偽情報の氾濫を後押しした。

●人間の編集者に分がある

生成AIによるコンテンツがネットに広がる中で、それを検証する手がかりの1つが、検出ツールだ。

筆者が確認したところ、「アンベルリシハール」の記事は、広く知られる生成AIによるテキスト検出ツール「GPTゼロ」でチェックするとAI生成の可能性が「100%」、別の検出ツール「ゼロGPT」でチェックすると「79.46%」だった。

だが、プロジェクトのページは「GPTゼロのような自動AI検出ソフトは信頼性に欠けるため、使用すべきではない」としている。

前述のレブル氏も「404メディア」の記事の中で、「AI検出ツールは不正確なことが多くて、GPT-2のような古いモデルにしか効果がない」と指摘する。

その点では、むしろ人間の編集者に分があるのだ、という。

ウィキペディアの記事には、構造化された独自のスタイルがあり、それを熟知した編集者の目から見ると、スタイルから外れた生成AIのテキストを見分けられる可能性は高いようだ。

レブル氏はこう説明している。

ウィキペディアの執筆ガイドラインと一般的な大規模言語モデルのキーワードの両方に精通した人間の方が、(ウィキペディアの)特殊な文脈の中で、AIのコンテンツを見分ける力が優れていると言えそうだ。

現場を知っている人間の強みは、こんな場面でも生かされている。

(※2024年10月15日付「新聞紙学的」より加筆・修正のうえ転載)