ChatGPTは心理カウンセラーになれるのか

ChatGPTに悩みを実際に相談してみた

「ChatGPT」は、OpenAIが開発した、今もっとも有名な生成系人工知能である。生成系人工知能(generative AI)とは、大規模なデータから会話やストーリー、画像、動画、音楽など、新しいオリジナルのコンテンツを作成できる AI の一種である。GoogleはBARD、MicrosoftによるBing Image Creatorなど、各社が生成系AIの公開を進めている。

基本的に誰でもスマホやパソコンで、無料で使うことができる。自動応答による対話も可能であり、心理相談や心理療法などカウンセリング的応用も期待されている。

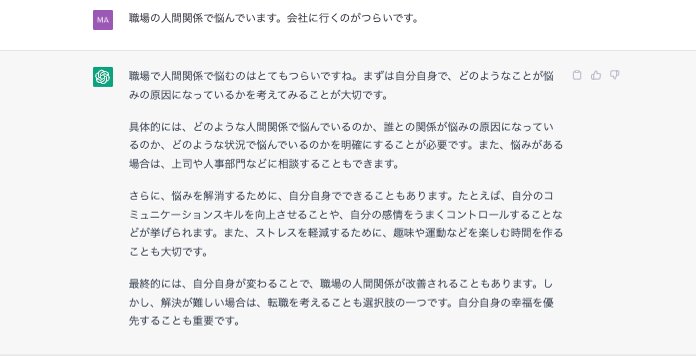

実際に、ChatGPTを使って、架空の悩み相談を行ってみた。

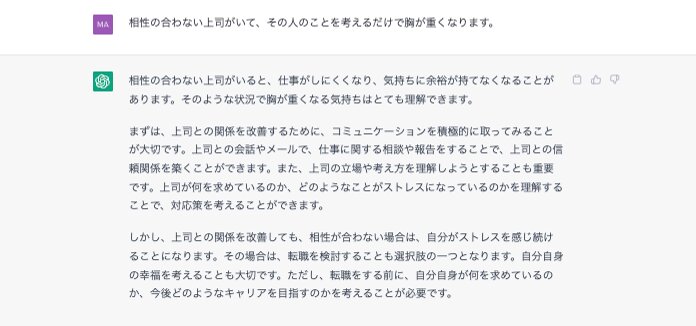

最初に共感のフレーズがあり、理路整然とした内容だが、やはり違和感がある。続いて、もっともポピュラーな悩みである「合わない上司」への対処法を聞いてみる。

アドバイスの内容はごもっともなのだが、どうも心に響かない。なにか授業を受けている感じがする。

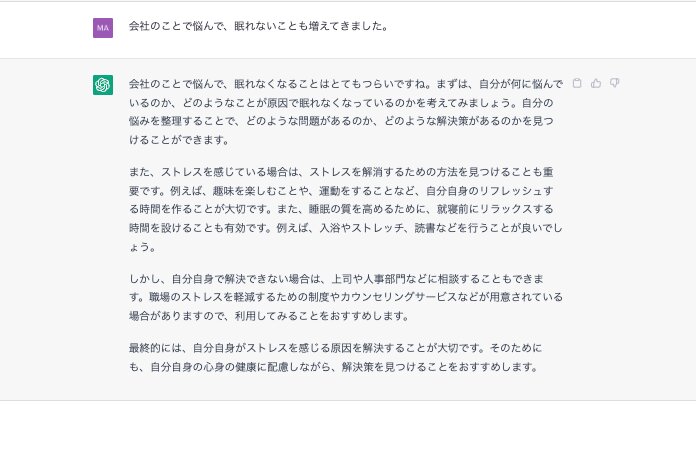

不眠で苦しいことを伝えてみる。

運動やお風呂など生活習慣への指導、さらに専門家への相談をすすめてくれる。内容としては、決して間違ってはいない。しかし、心に響かない、満足感がないのは、どうしてだろうか。

人工知能のもつ強み

AIは、膨大なデータの記憶やパターン化しやすい作業などが得意だという。大学生を悩ませるレポート課題も、ChatGPTにテーマを入力して作成を依頼すれば、レポートをすぐに作ってくれる。わたしも、某会合の挨拶文をChatGPTに試しに作ってもらったが、自分で書くより出来のよいものが作られてきて驚いた。

カウンセリングにおいても、ChatGPTの応用は検討されており、既に生成系AIを実装しているカウンセリングアプリも登場している(Awarefyなど)。海外の論文や記事をみると、心理サポートへのアクセス改善が、利点として挙げられている(Singh, 2023)。アメリカなど国土が広く、カウンセリング費用が高い国は、生成系AIをカウンセリングに使えれば恩恵は大きい。

今年4月29日にJAMA(アメリカ医師会雑誌)にて発表された論文が、ChatGPTのすごさを示している。ソーシャルプラットフォームから抽出した約200件の患者からの質問に対して、現役の医師とChatGPTにそれぞれ回答してもらった。回答を比較したところ、回答の質も共感姿勢も、ChatGPTのほうが医者を上回ったという(Ayers JW et al., 2023)。問診については、医師不要論も出てきてもおかしくない。

日本も、カウンセリングを受けたくても、需要に比べて供給は少なく、なかなか適切な場所が見当たらないことが多い。精神科クリニックの初診予約も、混んでいてとりづらいのも現実だ。困っていても相談することができない、受診ができないという人たちに対しては、サポートとして貢献できる可能性はあると思う。

AIカウンセリングの倫理的・技術的問題

現状では、問題のほうがやはり多い。ChatGPTでは、日本語で入力をすると翻訳プロセスが入ってしまい、回答に時間を要することがある。爆発的に人気が出たせいか、回答時間がかかることもある。だがこれはテクニカルな問題なので、解決していくだろう。

データ漏洩など個人情報保護の問題は、常について回る重大な倫理上の問題である。また、学習による適切な回答が用意されていない、あるいはAIの学習内容のバイアス(偏り)が修正されていない場合は、不適切なアドバイスを提供してしまうおそれがある。

またChatGPTを実際に使ってみて思うのは、相談や依頼の文章次第で、回答の精度や適切さが変わってくることである。どういう状況なのか、どのような答えがほしいのかなどを具体的に伝える必要があり、自分の意図を適切に言葉にする力や、依頼の仕方が求められる。

初めに例にあげたわたしの相談シミュレーションも、ChatGPTへの問い方がよくなかったのかもしれない。メンタル不調によって判断力やコミュニケーションや情動コントロール機能が一時的にでも低下した人が、使いこなせるかという疑問が残る。

AIカウンセリングの致命的な問題

AIは、相手の気持ちを考える共感力や、空気を読んだり行間を読んだりする能力は不得意だ。最初に挙げた相談例でも、最初に共感を示してはくれるが、紋切り型のあいさつに思えてしまう。

どうしてこのように空々しく思えてしまうのだろうか。これに関連して重要なのは、クライアント−カウンセラー関係だ。カウンセリングの癒しの効果は、助言の内容や妥当性よりも、思いやりや人間性といった人間独自の心性が大きく関わっている。言い換えれば、クライアントとカウンセラーとの間の協力と絆のレベルに大きく依存している。

人間は、痛みや愛着、不確実性などの経験を共有しているが、人工知能にはそのような経験はなく、架空の経験を学習するだけである。そのため、人工知能は、高いレベルのつながりや共感を必要とする治療法には適さないと考える。

学歴も業績も優秀だが、パソコン画面ばかりみて患者に共感を示せないエリート医師よりも、エビデンス不確かなあやしい治療法をすすめていても患者に優しく寄り添う姿勢を見せる医師のほうを、より信頼してしまうのと似ている。

さらに、生成的AIは、人間の表情やトーンの微妙なニュアンスを読み取ることが今のところまだできない。人間が容易に読み取れる重要な非言語的合図を見逃す可能性がある。そのため、その使用には人間の監視がまだ必要であり、安易な心理カウンセリングへの応用は、慎重でなければならない。

現状での結論

ChatGPTが人間のカウンセラーに取ってかわることは、まだないだろう。何十年も前から進行しているメンタルヘルスの問題を、即座に解決してくれるとは思えない。

しかし、メンタルヘルスサービスの効率を高めるという点では、大きな可能性を秘めていると考えられる。初診時のクライアントの基本情報収集や紹介状など文書の作成、相談・治療可能な場所の情報提供など、AIが専門家の仕事を軽減してくれることは可能だと思う。専門家を支援する役割をAIが果たせれば、カウンセラーや医師にとってはありがたいことだろう。

うつ病や不眠症に使われる認知行動療法は、物事のとらえ方や行動に働きかけてストレスを軽減する心理療法だが、AIアプリは相性がいい可能性がある(Creed et al., 2022)。学者がいくら認知行動療法のエビデンスを強調しても、認知行動療法の専門家に実際に診てもらうのは、今の日本ではなかなか難しい。認知行動療法アプリが普及すれば、より多くの人が受けられるようになり、まさに生成系AIがメンタルヘルスサービスを発展させた証になるだろう。

Ayers, J. W., Poliak, A., Dredze, M., Leas, E. C., Zhu, Z., Kelley, J. B., Faix, D. J., Goodman, A. M., Longhurst, C. A., Hogarth, M., & Smith, D. M. (2023). Comparing Physician and Artificial Intelligence Chatbot Responses to Patient Questions Posted to a Public Social Media Forum. JAMA internal medicine, 10.1001/jamainternmed.2023.1838. Advance online publication.

Creed, T. A., Salama, L., Slevin, R., Tanana, M., Imel, Z., Narayanan, S., & Atkins, D. C. (2022). Enhancing the quality of cognitive behavioral therapy in community mental health through artificial intelligence generated fidelity feedback (Project AFFECT): a study protocol. BMC Health Serv Res, 22(1), 1177. https://doi.org/10.1186/s12913-022-08519-9

Singh, O. P. (2023). Artificial intelligence in the era of ChatGPT - Opportunities and challenges in mental health care. Indian Journal of Psychiatry, 65(3). https://journals.lww.com/indianjpsychiatry/Fulltext/2023/65030/Artificial_intelligence_in_the_era_of_ChatGPT__.1.aspx