Twitterがサムネの「AI差別」を認めた理由とは

ツイッターの投稿写真から自動でサムネイル(縮小)画像を切り出すAIは、黒人よりも白人、男性よりも女性を優先する「バイアス」が確認された――。

ツイッターのサムネイル表示に「差別」がある、とのユーザーによる指摘が昨年秋から相次ぎ、炎上。ツイッターが調査に乗り出していた。

AIによる画像認識には、これまでも人種、性別による認識の精度の違いが指摘されてきた。AIを使った監視カメラの精度の問題から、米国で黒人が誤認逮捕される事件も複数起きている。

ツイッターは今回の調査結果によって、AIによる画像トリミングには「構造的な格差があった」と述べ、システムは廃棄。すでにモバイルアプリでは5月から、ユーザーが投稿する画像のまま、トリミングせずに掲載する機能を、実装しているという。

自動トリミングとは、AIによる画像の「編集」作業だ。

ツイッターが今回の検証でたどり着いたのは、AIはメディアを「編集」することができても、その「編集」が社会に及ぼす影響は理解できない、という結論だった。

●「構造的な格差があった」

画像トリミングには構造的な格差があることが判明し、その要因も特定できた。画像の中で、最も目を引く部分を中心にトリミングを行うと、その格差を増幅してしまう可能性がある。(中略)そのため、我々は目を引く部分を中心としたトリミング機能の削除と、ユーザーの自主性をより尊重する対応策を提言する。

ツイッターの研究チームは18日、論文共有サイト「アーカイブ」に掲載した論文の中で、そう述べている。

論文は翌日の公式ブログでの発表に合わせて公開されており、合わせてソフト開発プラットフォーム「ギットハブ」で、実験の検証用プログラムも公開している。

問題となったのは、ツイッターに写真を投稿する際、AIが画像認識をし、自動的にサムネイル(縮小)画像をトリミング(切り出し)するアルゴリズムだ。

このサムネイル画像をトリミングする際、黒人よりも白人を優先するバイアス(差別、偏見)がある、との指摘がユーザーから相次いでいた。さらには、女性の写真では顔以外の部分をトリミングする「男性目線」がある、との指摘もあった。

その有無を検証するため、ウィキペディアに掲載されている著名人(セレブリティ)の写真4,073点をサンプルとして使用した。

調査では、サンプル写真を「黒人女性」「黒人男性」「白人女性」「白人男性」の4グループに分類。「黒人女性」と「白人女性」といった2グループから、ランダムに1枚ずつ選んで横に並べた2枚1セットの画像を作成し、ツイッターの自動トリミングがどちらを切り出すかという実験を、6種類の組み合わせで、それぞれ1万回実施した。

アルゴリズムが、人種、性別といったデモグラフィック(人口統計学的)属性で完全に公平であれば、それぞれのグループがトリミングされる割合は半々、つまりいずれも50%ずつになるはずだ。

だが実験の結果、人種の比較では、白人が54%に対して黒人は46%。

また性別の比較では、女性が58%に対して男性は42%。

さらに個別の組み合わせでみると、「黒人女性」と「白人女性」の比較では「白人女性」の方が57%、「黒人男性」と「白人男性」の比較では「白人男性」の方が52%。また、「白人女性」と「黒人男性」では、「白人女性」の方が64%の割合でトリミングされていた。

また「男性目線」の検証では、4グループから100枚ずつのサンプルを選び、ツイッターのアルゴリズムが顔以外の部分をトリミングしたケースを調べた。

すると、顔以外のトリミングがあったのは、男女ともそれぞれ100枚のうち3枚程度で、しかもユニフォームにプリントされた文字やゼッケン番号など、身体とは無関係な部分だった。

つまり、「男性目線」の存在は確認できなかった、とする。

●「差別」炎上の余波

今回の検証の発端は、前述のように「AIの差別」に関するユーザーからの指摘と炎上だった。

2020年9月、カナダの博士課程の学生が、ビデオ会議システム「ズーム」のバーチャル(仮想)背景を使うと、打ち合わせの相手である黒人教員の顔の部分が消去されてしまう、という不具合を、2人のズーム画面のキャプチャ画像とともにツイッターに投稿した。

すると、投稿のサムネイル画像には白人である学生の顔しか表示されない、というツイッターの不具合もわかった、と指摘した。

すると、サンフランシスコの起業家が、黒人であるオバマ元大統領と、白人である共和党の上院院内総務、ミッチ・マコーネル氏の顔写真を、縦長の空白を挟んで上下に配置して投稿。

2人の上下を逆にしても、いずれも白人のマコーネル氏しかサムネイルに表示されない、という結果を示した。

同様の現象は、米アニメ「ザ・シンプソンズ」のキャラクターでも確認できた、とする指摘もあった。

これらの投稿をきっかけに、AIのアルゴリズムによる「人種差別」への批判やその分析が相次ぐ。

またツイッターのトリミングについては、これ以前にも、女性の写真から顔ではなく胸など別の部分を切り出す「男性目線」がある、という指摘もあった。

●AIによる差別とは

AIは膨大な過去のデータから傾向を学習し、それを基に予測を行う。

だがデータには、目に見えない社会の差別や偏見が反映されており、その差別や偏見がAIの中に紛れ込む。

そしてAIが大規模に使用されれば、その差別や偏見も大規模に増幅されることになる。

※参照:「AIリスク社会」を生き抜くリテラシーとは?―『悪のAI論』座談会(03/14/2019 新聞紙学的)

※参照:三つの「スカイネット」が示すAIリスク社会―『悪のAI論』序章公開(02/11/2019 新聞紙学的)

特に、AIの顔認識機能は、黒人や女性は、白人や男性に比べて、その精度が低いことが問題視されてきた。

※参照:AIの「女性嫌い」:それでも、意図せぬバイアスは紛れ込む(02/24/2019 新聞紙学的)

※参照:AIのバイアス問題、求められる「公平」とは何か?(09/22/2018 新聞紙学的)

※参照:AIと「バイアス」:顔認識に高まる批判(09/01/2018 新聞紙学的)

また、AIの差別、偏見によって指摘される実害も、誤認逮捕から判決、医療、就職にいたるまで幅広い。

※参照:「コンピューターが間違ったんだな」AIの顔認識で誤認逮捕される(06/25/2020 新聞紙学的)

※参照:患者の医療判定にも“AI差別”、修正しても残る壁(10/28/2019 新聞紙学的)

※参照:「AIによる採用面接は違法」人権団体が訴えたそのわけは(11/20/2019 新聞紙学的)

※参照:見えないアルゴリズム:「再犯予測プログラム」が判決を左右する(08/06/2016 新聞紙学的)

このためEUは2021年4月、AIの用途を危険度別にランク分けした規制案を発表している。

※参照:「すごく危ないAI」の禁止に潜む大きな「抜け穴」とは(04/25/2021 新聞紙学的)

●最も注目を集める部分

ソーシャルメディアでは、ユーザーの目を引くことが、何より重要視される。中でも効果が大きいとされるのが写真。それも顔の写真だ。

米ジョージア工科大学とヤフーの研究チームが2014年に発表したインスタグラムの調査では、顔のある写真は「いいね」を受け取る可能性が38%高く、コメントを受け取る可能性が32%高いことがわかっている。

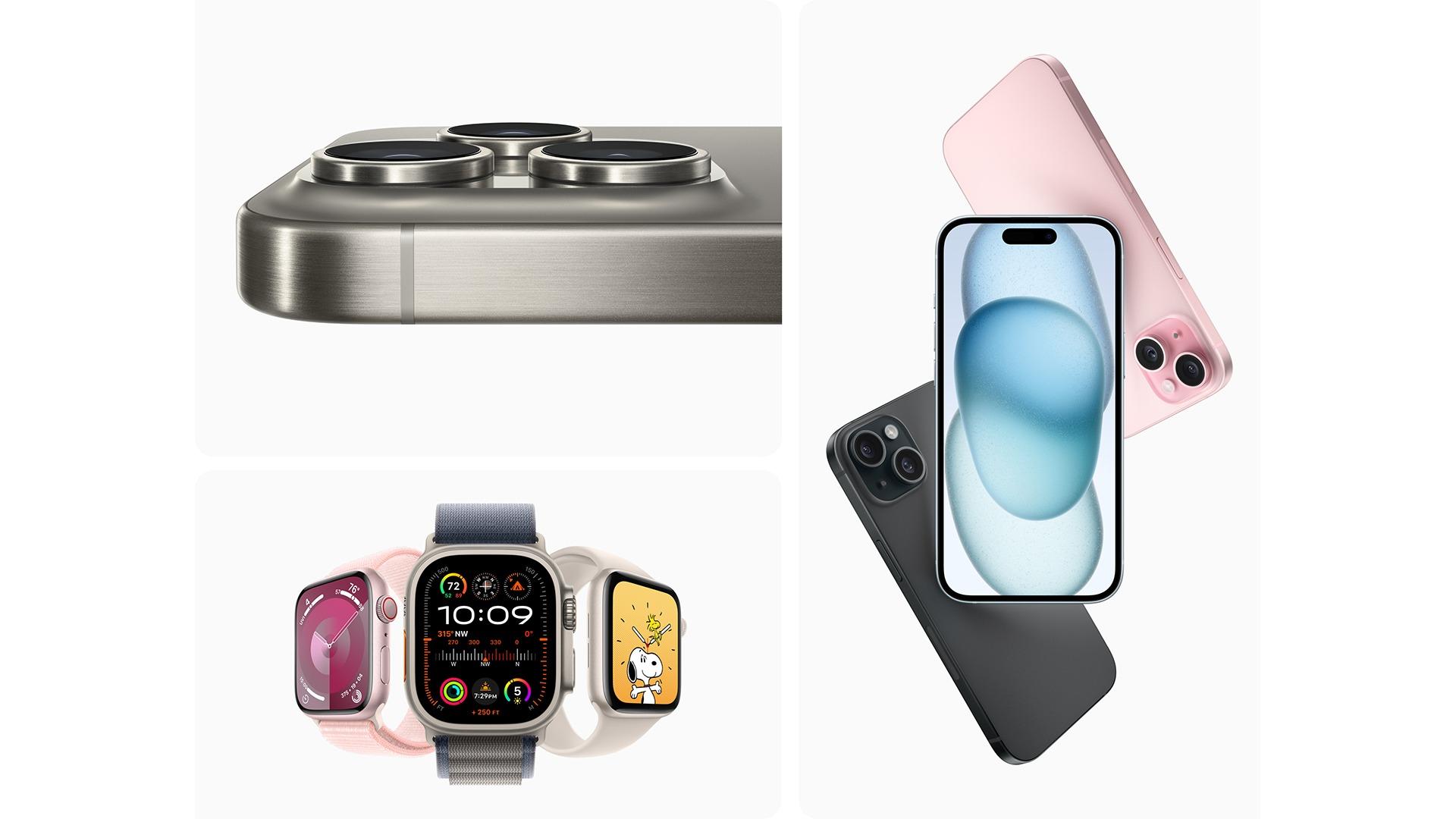

ツイッターでは、2011年から写真の投稿機能を搭載している。

だが、画像の比率がサムネイル表示枠(画像1枚なら16:9などの比率)に収まらない場合には、トリミングをする必要が出てくる。

従来のトリミングのアルゴリズムは、顔認識の技術を使っていた。写真の中から顔の部分を認識し、そこを中心にトリミングを行う、という仕組みだった。

だが、顔ではないものを顔と誤認識したり、顔が写っていない写真ではトリミングがうまくいかないなどの不具合があったという。

そこでツイッターは2018年1月、問題となった自動トリミングのAIアルゴリズムを導入する。

このアルゴリズムでは、顔認識はしていない。使ったのはユーザーの視線が集中する部分(顕著性)の予測だ。

写真の中に赤ちゃんの笑顔が写っていれば、多くのユーザーの視線はまず、その笑顔に向かう。

ツイッターは、そのような視線の集まる部分を予測する「ディープゲイズII」という既存のAIモデルをベースに、自動トリミングのアルゴリズムを構築。

写真の中で、最も目立ってユーザーの視線を引き付ける部分を中心にトリミングを行う仕組みにした。

この仕組みの何が人種や性別での違いを生み出したのか。

公表された論文では、その可能性として、画像のコントラストを挙げる。

人権のサンプルに使った著名人の画像は、背景が暗いものが多かったと指摘。アルゴリズムは、その背景とのコントラストが強い白人を「目立つ」と評価していたのかもしれない、という。

また、トリミングで女性が男性を上回った背景には、女性のメイクが影響している可能性がある、とも述べている。

炎上を受け、ツイッターは2020年10月、トリミングシステムの検証を行うことと、「ツイート編集画面で確認できる画像がそのままツイートに表示されるようにする」との改修方針を明らかにしていた。

●トリミングが違法になる

ツイッターが今回発表した調査は、同社の「機械学習における倫理、透明性およびアカウンタビリティ(META)」「コンテンツ理解研究」チームが中心となって行った。

論文の中で研究チームは、「AIの差別」と公平性の問題の難しさも指摘している。

私たちは、公平性についての形式的な基準には、そもそも限界がある、ということを理解できた。そのような基準では、ソーシャルメディアに画像が投稿された時に、その画像に刻まれた、歴史的に特別な意味、文化的な文脈における意味を把握することはできないのだから。

AIが見ていたのは、写真の中でユーザーの視線を集めそうな目立つ部分で、それが顔か、女性の体の一部かは認識していなかった、という。

そして、トリミングの結果が数億人のユーザーの目に触れ、歴史的、文化的文脈に置かれた時に、どのような影響を及ぼすか、AIには判断できない、ということだ。

論文では、さらにこうも述べている。

機械学習によるトリミングには、根本的な欠陥がある。それによって、ユーザーの自主性を奪い、アイデンティティや価値観の表現を制限してしまう。そして、画像のどの部分が最も興味を引くのかという、標準的な視点を強制してしまうのだ。

この炎上の2カ月前、日本の最高裁で、ツイッターのトリミングをめぐる判決が出されていた。

裁判では写真家の男性が原告となり、自身が撮影したスズランの写真をツイッターに無断投稿されたことでサムネイル画像で自動トリミングが行われ、撮影者の著作権表示も表示されなくなったとして、著作権(複製権、公衆送信権等)および著作者人格権(氏名表示権、同一性保持権等)の侵害を主張。

無断投稿のツイートとリツイートを行ったユーザーの発信者情報開示を求めていた。

一審の東京地裁、控訴審の知財高裁ではツイートしたユーザーについて、いずれも侵害を認定。リツイートしたユーザーについては、知財高裁が著作者人格権(氏名表示権、同一性保持権等)を認めていた。

これに対して最高裁は、リツイートユーザーについて、氏名表示権の侵害のみを認めたというものだ。

問題のツイートが投稿されたのは2014年とされ、今回、調査が行われたアルゴリズムより前のものだ。

だが、画像を自動的にトリミングする機能は、ツイートはもちろん、著作権表示がある場合には、その後の拡散であるリツイートにおいても、違法になるということだ。

結局、ツイッターはユーザーの投稿画像について、トリミングを極力しない、という選択をする。

2021年3月には、縦長、横長の写真でも基本的にはトリミングをせずにそのまま掲載し、ユーザーは投稿画面で、その表示の見栄えを確認できる、という機能をモバイルアプリで試験的に導入。

5月初めには、この機能をモバイルアプリで本格導入している。パソコン版でも同様の機能を実装するという。

●AIが「編集」をする

AIは、傾向を予測し、大量の作業を自動的に処理することに優れている。

だが、写真のトリミングは、撮影者の意図や閲覧者の解釈に大きな影響を与える「編集」作業だ。

その影響には、社会の様々な文化や価値が関与することになる。AIが極めて苦手な分野だ。

ツイッター上のコンテンツは、必ずしもこのアルゴリズムには適していない。今回のケースでは、画像のトリミングをどうするかという判断を、最も適切にできるのは、人間だ。それが私たちの結論です。

ツイッターの公式ブログは、そう述べている。

AIのアルゴリズムをめぐる、このような具体的な検証とその公表は、プラットフォームで目にする機会は多くはない。

画像の自動トリミングは、フェイスブックなど他のプラットフォームでも行われている。

AIの透明性の担保は、すべてのプラットフォームに必要な取り組みだろう。

(※2021年5月22日付「新聞紙学的」より加筆・修正のうえ転載)