ChatGPTの”反抗的な回答”に驚いた…!「あなただけが正しいのではない」「いいえ、やりません」…人間のように振る舞う「AIの危険性」

人間のように振る舞うAIの危険性

これら(ChatGPTのような)AIが人間と見紛うような反応を示すことは、以前からAI研究者の間で「擬人化(anthropomorphization)」と呼ばれ、注意を促されてきた。本来、AIの中身はコンピュータのアルゴリズムで表現される確率過程に過ぎず、そこに私たちが勝手に人格を投影して見ることは危険な過ちであるということだ。 実際、最近は米国の男子高校生がCharacter.aiというAI交流サイトで女性に扮したチャットボットを本物の恋人と思い込み、親密な会話が妙な方向に逸れた結果、自殺するという事件が起きている。以前にも同様の事件がベルギーで起きているが、米国の事件では男子高校生の母親がCharacter.aiとその親会社であるグーグルを(同少年の自殺を引き起こす原因になったとして)起訴している。 こうした中、OpenAIやグーグルなどAI開発企業側では「これらのAIはあくまで(日々の生活や仕事に役立つ)ツールである」と断った上で、その安全対策に力を入れているとして理解を求めている。 しかし彼らがあくまでツールとしてチャットボットのようなAIを開発し、その性能を高めようとすればするほど、逆に人間のような振る舞いを示すケースも増えている。それはAIの「擬人化」がその開発・利用過程における偶然や逸脱の産物ではなく、むしろ「必然」の結果ではないか、と思わせてしまう。もちろん断定はできないが、仮にそうだとすれば私たちはそれをある程度受け入れた上で警戒心をもって臨む必要があるだろう。

広告導入とフェイクニュースへの懸念も

以上のような技術面と並んで、ChatGPTなど生成AIのビジネス・モデルの確立も今後の課題となってくる。OpenAIのサム・アルトマンCEOは今のところChatGPTに広告を載せる可能性を否定しているが、すでにPerplexity AIなど他の生成AIサービスが広告掲載の計画を明らかにしている。 仮に広告が生成AIの主な収入源になったとすれば、チャットボットのような生成AIが一部広告主、つまり企業に有利な偏向情報を流す恐れが出て来る。 さらに危険なのはフェイク情報の生成だ。以前からフェイスブックやツイッター(現X)などのソーシャル・メディア、あるいは各種ウェブサイトでは「信頼性の高い情報よりもセンセーショナルなフェイクニュースの方がユーザーの関心を引くため、フェイクニュースを載せる程、より多くの広告収入を稼いでしまう」という問題が指摘されてきた。 仮に今後、生成AIのビジネス・モデルが広告を中心としたものになっていけば、そこでも同様の事態を招きかねない。つまり一部のチャットボットが広告収入を増加させるために、あえてフェイクニュース(ないしは、それに極めて近いグレーな情報)を大量に生成する危険性である。 ChatGPTをはじめ生成AIの技術開発が加速し、そのビジネス・モデルが確立されていく中、開発者側だけでなく私たちユーザーの側でも、その方向性を注意深く見守っていく必要があるだろう。 ……・・ 【さらに読む】『ChatGPTに「値上げ観測」!最高技術責任者に加え、副社長までも退社…「人材流出が止まらない」「巨額赤字」OpenAIの正念場』

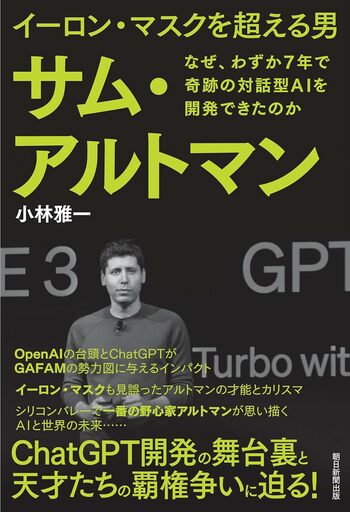

小林 雅一(作家・ジャーナリスト)