患者の「声」取り戻すAIアプリ開発、口の動きから本人そっくりに…大阪大などチーム

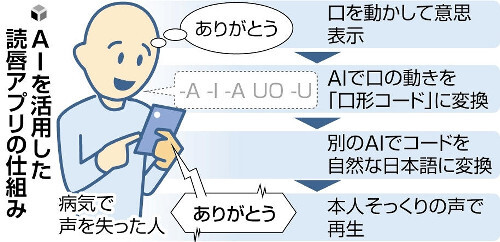

病気で声を失った患者の口元の動きから話そうとしている内容を人工知能(AI)で推定し、本人そっくりの人工音声を流す「読唇アプリ」を、大阪大などの研究チームが開発した。患者の意思疎通が楽になるといい、チームは実用化を目指し、大阪大病院で患者に試験的に使ってもらうことを計画している。

喉頭がんや下咽頭がんなどの治療では声帯を切除して声を失う場合がある。代替の発声方法として、食道の粘膜をふるわせる「食道発声」や、気管と食道の間に穴をあけて器具を取り付ける「シャント発声」などがあるが、元の声とは異なる上、習得が難しく、体への負担も大きい。

日本語は母音が5種類しかなく、例えば「あ」と「か」では口元の動きがほぼ同じため、母音が10種類以上ある英語などより読唇が難しいとされる。

チームの御堂義博・特任准教授らは、母音に加え、前後の音の並びによって変化する口元の動きを16種類に分類した「口形コード」という手法に着目。まず話している口元の膨大な映像と、その動きに対応するコードをAIに学習させ、口元の動きをコードに変換する手法を開発した。

さらに別のAIを使い、コードを自然な日本語に置き換える2段階のシステムで、話そうとしている言葉を推定できるようにした。

事前に録音した患者本人の声をもとに、人工音声でそっくりに再現するシステムも組み合わせ、アプリを完成させた。語尾が不正確になりやすいなどの課題はあるが、大半は意味が伝わる会話ができたという。

大上研二・東海大教授(耳鼻咽喉科・頭頸(とうけい)部外科)の話「練習が不要で体への負担もないため、声を失ってすぐに使えるのは大きなメリットだ。より即時性を高め自然な会話に近づけられれば、患者さんにとって大きな福音になる」