Hailuo AI、Mochi Preview、Stable Diffusion 3.5、OmniGen……10月試した生成AI

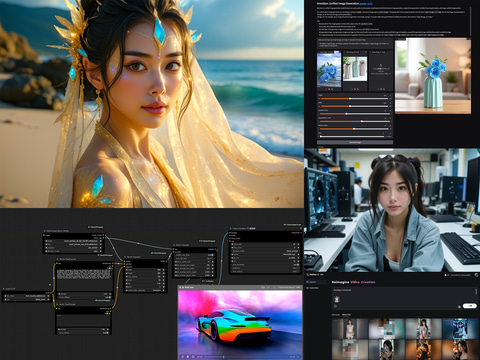

今月10月は物凄い勢いでいろいろな生成AI関連がリリースされた。その中でも実際試したいくつかの中から動画系2つ、画像系1つ、マルチモーダル系1つをご紹介したい。 【画像】Hailuo AI。右下のように規約違反に引っかかると×が付く。モザイク部分は肌色過多など自主規制(笑)動画自体は問題なく生成されている ■ Hailuo AIとMochi Preview 動画に関しては6月の記事でLuma Dream Machineに触れているが、10月初旬、いきなり登場したのがHailuo AI。1枚の画像から6秒の動画を生成できるのだが、うまく行った時は驚くべき仕上がりとなる。 筆者は運良くβテストのタイミングで知り、結構いろいろなものを作れたので、その中から肌露出ほどほど(笑)なのを使ってご紹介したい。 以下の画像2枚は、Hailuo AIログイン後の操作用UIと、動画を生成するのに使った写真6枚。動画は7本をつなげているので、本当はもう1枚画像があるのだが、レイアウト上半端になるため1枚省略している。すべてFLUX.1 [dev]で生成した画像だ。 操作用UIは至って簡単。画像をアップロード、動きに関するプロンプトを英語で入力する。もしくはプロンプトなしでも良い。またプロンプトの内容を自動拡張ON/OFFするアイコンもある。ボタンに30と書かれているのは動画生成1回30 creditsを使うと言う意味だ。このボタンを押せば生成を開始する。 7枚の画像から7本の動画を生成し、1本につなげた動画を掲載した。いかがだろうか?1枚の画像からとは信じられない動画が出来上がる。動きもAI動画でありがちなヌルヌルした感じではなく、普通に撮影した映像っぽいのもなかなか凄い。 筆者にとって嬉しいのは“今のところ”ほかの動画生成サービスよりNSFW検閲が緩いこと。水着グラビア程度なら普通に生成可能だ。筆者のXアカウントにいろいろ載せているので興味のある人は別途ご覧いただきたい。水着なのでここには載せられないが、ハロウィーンのクラブイベント的な動画は圧巻。多分、普通にInstagramなどで流れると「へーこんなパーティあったんだ!」としか思わないだろう。 余談になるが、最初や最後は何か喋っている。とにかくHailuo AIは良く喋る。何を言ってるのか気になるところ(笑)。 料金プランは、Free、Standard、Unlimitedと3つあり、順に$0/$9.99(月額。$14.99から値引き中)/$94.99。これでStandardは1,000 credits per month、Unlimitedは名前の通り無制限。1動画生成するのに30 credits必要なため、Standardだと33回/月と結構少ない。 Freeはアカウント作ると毎日9時(日本時間)に100 creditsが付加される(ただし翌日に繰り越しはない)。つまり毎日3回までは生成可能となる。ほかのプランとは違い、queue待ちが長く、いつできるかは分からない状態。とは言え、筆者は気が向いた時(もしくは動かしてみたい画像が出た時)にちょっと試すだけ。仕事している間にできているのでFreeプランで今のところ十分遊べている。もちろん元画像は実写でもOK。動かしてみたい写真があればぜひ試して欲しい。 このレベルがローカルPCでできるのはいつ?っと思っていたところに、Mochi Previewがリリースされた。もともとは生成するのにNVIDIA H100が4台必要と、とんでもない代物だったが、その後、GeForce RTX 4090 = VRAM 24GBでもComfyUIで生成可能になり、そのタイミングでの試用だ。 上記のHailuo AIはimg2vidだったのに対して、Mochiはtxt2vid。プロンプトからいきなり動画を生成する。従って事前にどんな絵なのか知る由もなくぶっつけ本番だ。ここが元画像のあるHailuo AIとの大きな違いとなる。 加えて、プロンプトはザックリ書いたものだと、ザックリした動画しか出ず、それなりに出すには英文で指示する必要がある。このため筆者はローカルのLLMを使い、ザックリなtag区切りを英文化、プロンプトにしている。 掲載した動画は車、アイドルライブ、銀座で買い物……的なのをつないで1本化したもの。初めの車はうまく動いているが、残り2本、人が絡むと大きく崩れる。ただ崩れていない部分は結構なクオリティがあり、完全に生成できればローカル生成としては相当なレベルになることが予想できる。ただし、GeForce RTX 4090を使っても6秒の動画を作るのに約30分かかった。この点はうーんっと言ったところか。 ここに、Mochiで作り、人もちゃんと崩れないで動く動画がある。プロンプトも載っているのだが、物凄く細かく書かれている。実際はLLMを使いUpscaleしたそうだが、掲載したアイドルライブや銀座で買い物は同じ手法でも崩れる。なかなか難しいところ。 Mochiはtxt2vidだが、ほかに同レベルの完成度のものとしてCogVideoXが挙げられる。こちらはimg2vid。まだ試してないが、ネットにあるサンプルを見るといい線までできている。オープンソース版+ローカルPCでHailuo AIレベルが作れる日はいつなのだろうか!? ■ Stable Diffusion 3.5 LargeとTurbo 6月12日、ローカルPCで生成可能な2BのStable Diffusion 3 Mediumがリリースされたが完成度がイマイチ。その後、修正版を出すと発表していたものの、なかなか出ず、やっと10月22日にStable Diffusion 3.5となってリリースされた。 公開されたのは8BのStable Diffusion 3.5 Largeと、その蒸留版Stable Diffusion 3.5 Large Turbo。 さっそく同一プロンプトで、SDXL、Stable Diffusion 3 Medium、Stable Diffusion 3 Ultra、FLUX.1 [dev] / 1MPと比較したのが以下の画像となる。 プロンプト photo of a powerful GPU-equipped computer scattered around a research lab, with a beautiful japanese woman like a k-pop idol. creating AI images. 20 years old. まずSD 3.5 Largeはこれ以外にもいろいろ出しているが、背景や物などは物凄い描写力。ただ人に関しては、SD 3 Mediumで体が崩れるなどがあり、おそらくデータセットごと入れ替えたのだろう。随分テイストが変わった。また超リアル系より、イラスト系、そしてリアルなファンタジー系の方が得意っぽい。ハマると凄まじい絵が出てくる。 が、どうも日本人を含むアジア系をプロンプトで指定すると、ご覧のようにいかにも生成AI画像っぽい顔になる(西洋系はそうでもない)。データセットのアジア人系の多くは何かほかの生成AI画像を使ったのでは?と個人的には思っている。 加えて生成される画像はプロンプトの内容に結構敏感に反応。試しにLLMを使って以下にUpscaleしたプロンプトだと2番目の絵となる。顔も含め随分雰囲気が落ち着いた。いずれにしてもGeForce RTX 4090を使い約14秒ちょっと。FLUX.1 [dev]が8秒ちょっとなのでかなり重い処理となる。 A photo showcasing a powerful GPU-equipped computer surrounded by various research lab equipment, including monitors displaying complex data visualizations and holographic projections. A beautiful 20-year-old Japanese woman with the allure of a K-pop idol is seated at the workstation, focused on creating AI images using advanced software. Capture her intense concentration as she navigates through the intricate world of artificial intelligence. 対してSD 3.5 Large Turboは普通の顔が出てくる。ことアジア系に関してはこちらの方が調子良いほど(ただし絵は平面的)。蒸留モデルだからと言うのが主な理由だと思われるが、何とも皮肉なものだ。作品的な画像ではなく、プレゼンなどに入れる普通の画像を出すならこっちの方がいいかも知れない。かかる時間はGeForce RTX 4090で1秒半未満。とてつもなく速い。 リリース後、既に1週間ほど経っているが、civitaiではLoRAなど関連モデルはあまり登録されていない(学習に必要なai-toolkitとs-scriptsは対応済み)。FLUX.1 [dev]の時は、SD 3 Mediumにガッカリしていたところへの登場だったことと、その完成度の高さもあり、一気に流行った感があったが、様子見なのだろう。 なお、本原稿が載る前、10月29日に2.6BのStable Diffusion 3.5 Mediumもリリースされた。Stable Diffusion 3.5 Largeの生成が少し重いだけに、その完成度や生成速度が気になるところ。 いずれにしてもsaiのSD系はSD 1.5やSDXLを見れば分かるように、ベースモデルで終わりではなく、その後、チューンされ、いろいろなLoRA/checkpointが出て「お!」っとなるのがパターンだ。今から何が出るのか楽しみにしている。 ■ OmniGen 以前、Claudeを使い、画像をアップロード、その画像の内容をテキストで書き出す=VLLMの話をしたが、OmniGenは、テキストでなく、元画像からプロンプトで指定した内容に変えて画像出力するマルチモーダルとなる。また元画像がなくても単独で画像生成可能だ。 デモはここ。サンプルを見ると、1枚の写真から同じ人物でポーズや背景を変え生成、2人写っている内1人を使い状況を変え生成、2枚の写真それぞれに写ってる人を1枚の画像にして生成、2つの異なるものから1つのものを生成(花/花瓶?)、ControlNet / OpenPoseの骨情報を使い構図を固定して生成……など、いろいろなことができるのが分かる。 Githubはここにあり、git clone後、app.pyのspaces関連2カ所(4行目、12行目)をコメントアウトすればこのデモアプリがローカルPCでも動作する。以下、ローカルPCで実際生成した時のWebUIとその結果などを掲載する。 ちょと使ってみて分かったのは、元写真の顔の面積が小さめだとあまり似ない(恐らく物でも同じだろう)。バストアップ程度が望ましい感じか。また元画像なし/プロンプトのみの画像生成は、SDXLと同レベル(もしくはそれ以上)と思われるが、FLUX.1 [dev]の倍近く時間がかかるのが痛いところか=であればFLUX.1 [dev]を使う。 この手の生成は、顔や衣服を学習させLoRAにして……というのが一般的だが、ワンショットでできるとなると、用途は広がりそうだ。今後に期待したい。 以上、10月試した生成AI画像/動画関連、3つをご紹介した。上記した以外、LLM系なども10月は山盛りの発表があり、一人では追いきれない状態になっている。中でも動画生成は毎月進化している感じで物凄い勢いだ。今年も残すところ2カ月。また何かいきなり出るのか!?

PC Watch,西川 和久