認識率98%――字幕で伝えるニュース、NHKの音声認識技術の今

ニュース番組や情報番組に付与される字幕は、高齢者や耳の不自由な人をサポートする大切な機能です。字幕化を推進する総務省のまとめによれば、総放送時間に占める字幕放送時間の割合は、NHKの84.4%がトップ(2016年度)。NHKが字幕放送に力を入れられる背景には、映像内の音声を自動認識してテキスト化するシステムの開発が大きく影響しています。

NHKの「音声のテキスト化」の技術は視聴者に直接伝える字幕だけでなく、制作の現場での活用も見込んでいるのだそう。さらに機械学習とも連携させることで、取材で得た情報をより正確により速く伝えることを目指しているといいます。

そこで今回はNHK放送技術研究所の佐藤庄衛さんに、すでに実用レベルに達しつつある音声認識技術が報道の現場でどう活用されているのかをお聞きしました。

取材・文/友清 哲

編集/ノオト

字幕のために開発が始まった音声認識技術

最新の音声認識技術で、アナウンサーが話す内容が自動でテキスト化される様子

――番組出演者のセリフがリアルタイムで字幕になっていく様子に驚かされます。NHK放送技術研究所では、いつごろからこうした音声認識技術の研究に取り組んでいるのでしょうか。

開発の歴史は意外と古く、1990年代には研究がスタートしています。そして90年代半ばには大相撲の決まり手を音声から認識できるレベルに達しました。その後2000年からニュース番組でアナウンサーが話している内容を対象に、音声認識システムを使って自動的に字幕を入れるようになりました。日本のテレビ業界におけるリアルタイムでの字幕化は、これが初めてのケースですね。

<放送技術研究所 佐藤庄衛さんのプロフィール>

1993年入局。仙台放送局を経て、1995年から放送技術研究所で音声認識の研究に従事。現在、放送技術研究所ヒューマンインターフェース研究部上級研究員。博士(工学)。

――当時、ニュース番組で字幕の必要性が高まった理由は何だったのでしょう?

まず大前提として、字幕には高齢者や耳の不自由な方にニュースを届けるという目的があります。アナログ放送時代は、「クローズドキャプション(表示の有無を切り替えられる字幕)」を使うためには特別な機器が必要でしたが、2003年に始まった地上デジタル放送ではテレビ自体の機能で字幕の表示・非表示が切り替えられるようになりました。それに合わせて、総務省が字幕放送のさらなる普及を目指すという目標を掲げたことから、取り組みが本格化しました。

またこの当時、災害や事故などの避難を伝える重要なニュースが耳の不自由な方々に伝わっていなかったことが発端となって、字幕でニュースの情報を届けたいという声が挙がっていたことも大きな理由の1つです。

昨今、民放で放送されているバラエティー番組の多くでは、耳で聞くだけでは内容を正確に理解しづらい言葉をテロップのような「オープンキャプション(常時表示される字幕)」で伝えていますが、字幕放送(クローズドキャプション)では、アナウンサーの明瞭な音声も含め可能な限り全てを文字でお伝えします。技術的にできるところからカバーしていこうと、発音や発声が認識しやすいアナウンサーのセリフの字幕化から着手したわけです。

――やはり、番組内容や語り手によって発音・発声が異なる点が、音声認識技術における障壁ということですね。

アナウンサーの話す言葉は比較的認識しやすいので、音声のクリアなニュース番組では自動音声認識の認識率は98%に達しています。ただ屋外でのロケの場合はどうしてもノイズが多くなりますし、情報番組でのくだけた話し言葉や複数の人間が同時に言葉を発する状況では、やはり認識の難易度は高くなります。そこでNHKでは自動音声認識システムだけでなく、さまざまな方式を使い分けながら、あの手この手で字幕化に取り組んでいます。

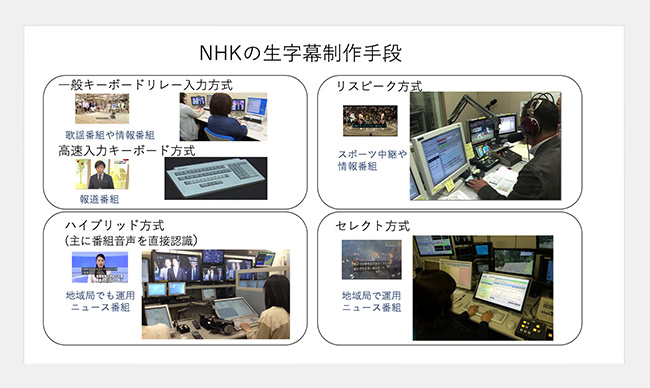

――現在、実際にNHKで使われている字幕制作の手法は、どのようなものでしょうか。

佐藤庄衛さん提供

現在は番組によって4つの方式を使い分けています。まず、高速入力に適した特殊なキーボードを用いて、人力で字幕を起こす「キーボードリレー方式」。それから、番組音声を直接認識するシステムと、人力での作業を併用する「ハイブリッド方式」。そして、ニュースなど元原稿が存在する番組では、音声認識結果からどの原稿を読み上げているのかを推定して字幕化する「セレクト方式」も活用されています。

さらに、スポーツ実況や情報番組では、実際に放送されている音声を、別室でアナウンサーが読み上げ直し、それを自動認識させる「リスピーク方式」が採用されることも。多少のタイムラグは生じますが、ノイズの入らない静かなブースで入力することで認識精度を高めるやり方ですね。

取材した音声の「テキスト起こし」にも応用

――音声をテキスト化する技術は、字幕以外にどのような用途がありますか?

テレビ報道の舞台裏には、取材内容を速く的確に番組に反映させるために、撮影された映像素材に含まれる音声コメントをテキスト化し、社内へ共有する工程が必ずあります。音声認識技術によってそのテキスト起こしを自動化できれば、制作サイドの作業を大幅に軽減できるのではないかと期待しているんです。

2017年冬から実証実験を始めました。このシステムをどう運用していくかは局全体の判断になりますが、着実に実用レベルに近づきつつあると思います。

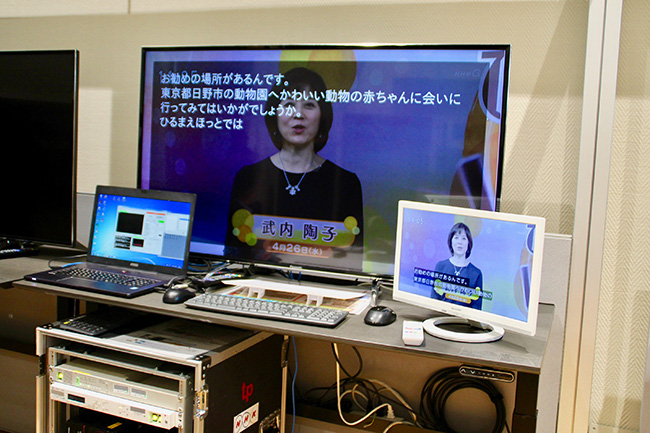

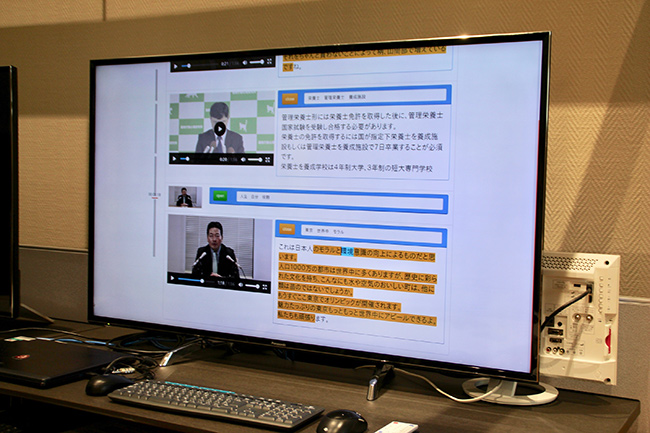

現在、報道の現場にて実証実験中の音声認識システム

――また、音声認識技術システムのインターフェースも、非常に洗練されていますね。

現場で撮影された映像をサーバーにアップロードすると、システム内でカット点ごとにサムネイル化して表示されます。この際、各場面を特徴づける単語を自動的に抽出する仕組みになっているので、番組制作で必要なシーンだけをキーワードから頭出しできます。また、映像から自動認識されたテキストを部分的に選択すると、その部分から映像が再生されるので、間違って起こされたテキストがあっても修正や変更にも対応しやすくなっているのが特徴です。

――こうした使い勝手の良さは、制作スタッフの人々の働き方改革にも寄与するのでは?

そうですね。今のところは従来のテキスト起こしにプラスして、システムへの映像アップロードという新たな作業が増えている段階ですが、映像からのテキスト起こしにかかる時間は従来比で30%減というデータもあります。今後、機械学習によって認識精度はさらに上がっていきますから、いっそう使い勝手は良くなるはずですよ。

機械学習で話し言葉から書き言葉への自動変換も可能に

――機械学習はどのような部分に生かされているのでしょうか。

たとえば、話し言葉ならではの言葉のつなぎ方などは、音声とそれに対応するテキストの組み合わせパターンを学ぶほど、文章として読みやすく書き起こされるようになります。具体的には、実際には「……と思うんですが」と出演者が話しているシーンでも、テキストでは「……と思いまして」と起こされるなど、話し言葉と書き言葉の修正を自動で判断できるようになっています。

――現在は実証実験中とのことですが、このシステムがNHK内全体で活用されるようになる見通しは?

まだ実証実験をはじめて2~3カ月なので先のことはわかりませんが、今のペースでいけば、2020年までにはより高い精度で実装できるのではないかと思っています。

――音声認識技術によって、視聴者のテレビ体験は今後どのように変わってくでしょうか。

技術者としては、番組制作の効率やスピードの向上、それに携わるスタッフの省力化で、番組そのもののクオリティーが高まることを願っています。その意味で、このシステムは正確さだけでなく速さや使い勝手も重要で、まだまだ改良できる点が多々あるでしょう。そして、その結果として視聴者の皆さんに、より正確な情報が広く伝わるようになれば理想的ですね。

お問い合わせ先

このブログに関するお問い合わせについてはこちらへお願いいたします。