IaaSの“キホンのキ”に立ち戻るAWS、GPUを電力効率とコスト面で補完する「Trainium2」などのカスタムシリコンに注力

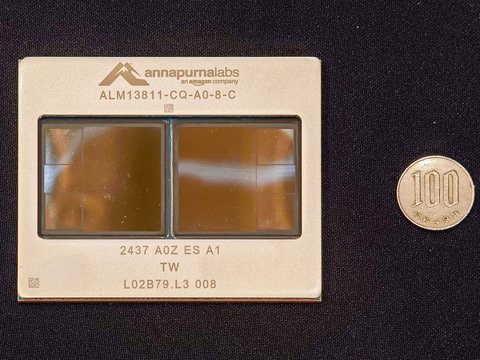

米Amazon Web Services(AWS)は、先週に米国ネバダ州ラスベガスにおいて、同社の年次イベント「re:Invent 2024」を開催した。その基調講演などのリポートはすでに別記事でお伝えしている通りだが、本記事ではre:Invent 2024の会期中に明らかになった、ハードウェアに関する発表についてお伝えしていきたい。 【画像】AWS AWSユーティリティコンピューティング担当 上級副社長 ピーター・デサントス氏 今回のre:Invent 2024でAWSがスポットライトを当てたのは「Trainium2」と呼ばれる生成AI向けのAIアクセラレーターだ。高まり続けるAI学習ニーズを満たすためにGPUへのニーズは高まるばかりだが、そのGPUの弱点は電力とコスト。特にファンデーションモデル開発するAIモデルベンダーや、一般消費者にAIサービスを提供する、B2CのITベンダーのコスト負担は増大するばかりで、GPUに替わる選択肢が求められている現状を背景に、Trainium2のようなソリューションに注目が集まっている。 ■ 祖業の「IaaS」へと立ち戻るAWS、CPU、GPU、ストレージなどハードウェア関連の発表が多数 もともとのAWSは、IaaS(Infrastructure as a Service)を提供するCSP(クラウド・サービス・プロバイダー)としてスタートしており、今でもIaaS事業では、Microsoft、Google、OCI(Oracle Cloud Infrastructure)を引き離してダントツのトップであることは変わりがないのだが、近年のAWSは、ほかのCSPに比べて弱点となっている、SaaS(Software as a Service)事業に力を入れている印象が強かった。 実際、昨年のre:Invent 2023ではSaaSとなるAmazon Qを発表したし、2023年にはAmazon Bedrock、そしてそれ以前からは、マシンラーニング/ディープラーニングAI向けのAmazon SageMakerのようなサービスの展開に力を入れてきた。近年のre:InventではそうしたSaaS関連、特にマネージドサービスを中心とした発表が大半で、AWSの祖業と言ってよいIaaSは、まるでおまけのように発表されるというのが通例だった。 しかし、本年のre:Invent 2024ではその様相がだいぶ変わっていた。もともとそうしたIaaS関連の発表などが多かった、会期初日(12月2日、現地時間)夜に行われるAWS AWSユーティリティコンピューティング担当 上級副社長 ピーター・デサントス氏の基調講演「Monday Night Live with Peter DeSantis」では、ほぼすべてがハードウェアの話で、昨年AWSが発表したAIアクセラレーター「Trainium2」を搭載したスーパークラスターがどのように構成されているのかなどに関して、ほとんどの時間が割かれた。 それだけではなく、翌日(12月3日、現地時間)に行われたAWS CEO マット・ガーマン氏による全体基調講演では、最初のテーマは、AWSが展開するカスタムシリコンで、昨年AWSが発表したArm CPUとなる「Graviton4」が紹介され、その「Trainium2」を採用したEC2のインスタンス「Trn2」および「Trn2 UltraServers」を発表した。 そしてその次に発表されたのは、ストレージサービスAmazon S3の機能強化に関する発表だ。近年のITではデータを保存するだけでなく、それをどう利活用するかが焦点になっており、AWSの顧客にとって自社のデータを保存しているS3の機能強化には、やはり注目が集まった。 世の中的な注目は、その後古巣に里帰りとなったAmazon 社長 兼 CEO アンディ・ジャシー氏が発表した、Amazonが開発した高性能な生成AIファンデーションモデル「Amazon Nova」に集まっていたことは否定できないが、注意深く基調講演を見ていると、そうしたハードウェア関連の発表が増えたなという感想をもった参加者が多かったのではないだろうか。 ■ AI学習の演算ニーズを背景に注目が集まるNVIDIA GPUのインスタンス AWSがそうした発表を行っている背景には、高まり続けるばかりの生成AIの学習の演算ニーズという事情がある。言うまでもなく、生成AIのファンデーションモデルの構築に必要となる学習を実現するための、NVIDIA GPUへのニーズだ。現在、NVIDIAのGPU、特に生成AIに活用されるデータセンター向けのGPU(H100やH200など)は入荷し次第売れているという状況で、世界中で在庫がないという状況である。 このため、CSPがNVIDIAから購入して構築しているGPUインスタンスへのニーズも高まるばかりで、5月と11月のMicrosoft Ignite/Build、9月に開催されたOCIのOracle Cloud World、4月のGoogle Cloud NextといういずれのCSPのイベントでも、NVIDIA GPUの新しいインスタンスの導入がうたわれている。特に2024年3月にNVIDIAが発表した新GPUアーキテクチャベース「Blackwell」ベースの製品に関しては、どのCSPも「うちが初めて導入する」と宣言するなど、まさに奪い合いの様相を呈している。 今回AWSも、Blackwellベースの新しいインスタンス「P6」を2025年初頭から投入すると計画だと明らかにしている。現在AWSは、H100ベースのP5、H200ベースのP5eを提供しているが、それらに加えてP6を導入することで、高まり続けるGPUへのニーズに対して答えていく計画だ。 P6の詳細について、AWSからは何も発表されていないが、NVIDIAからは、GB200 NVL72(1ラックで72基のBlackwellと32基のGrace GPUを搭載しているシステム)ベースで、AWSが独自に開発した水冷デザインに、AWS独自のネットワークスイッチとストレージサーバーから構成されているシステムであると明らかにされている。 ■ AWSにとってTrainium2は、大電力とコストが弱点のGPUを補完する製品 今回、AWS CEO マット・ガーマン氏は「AI学習ニーズのほとんどはGPUだ」と述べ、現状では、AI学習がGPU(AWSの場合はAMD GPUは採用されていないのでNVIDIA GPU)上で演算されているという現状を明らかにした。 そうした現状を認めながら、AWSは同時に別の選択肢として同社が自社開発したカスタムシリコン「Trainium2」を採用した「Trn2」、「Trn2 UltraServers」という2つの新しいEC2インスタンスの提供開始を明らかにした。 Trn2は、1つのラックで16基のTrainium2が搭載されているシステムになっている。チップとチップはNeuronLinkと呼ばれるAWS独自開発のインターコネクトでスケールアップされており、FP8の精度で20.8PFLOPS、スパース性を活用したFP8では83.2PFLOPSの演算性能を実現している。 Trn2 UltraServersは、そのTrn24つ分を、NeuronLinkを利用してスケールアップしたもので、64基のTrainium2がソフトウェア的に1つのTrainium2として利用できるようになる。Trn2 UltraServersでは、FP8の精度で83PFLOPS、スパース性を活用すると332PFLOPSという演算性能を実現し、ファンデーションモデルを開発するような大規模な演算装置を必要としているような顧客に、GPUに替わる選択肢を選択する形になる。 こうしたTrainium2は、NVIDIAのGPUに競合するような位置づけの製品なのだろうか?AWS コンピュート/AI製品担当部長 ラホール・クルカルニ氏は「Trainium2は、顧客に新しい選択肢を提供するというのがわれわれの位置づけだ。Trainium2は、GPUに比べて電力効率が高く、それに伴ってコスト対効果が高い製品になっている。AI学習では、ハードウェアコストが大きな課題になりつつあり、そうした大量に学習を行う顧客にとってTrainium2は魅力的な選択肢になると考えている」と述べ、Trainium2はNVIDIA GPUを置きかえるようなものではなく、GPUのコストが高すぎると考えているような顧客に対して新しい選択肢を提供する、補完的な製品だと現状では位置づけていることを明らかにしている。 ■ 電力あたりの性能や費用対効果で勝るTrainium2、Appleは50%の効率改善を確認 実はこの位置づけは、Arm CPUのGravitonシリーズのそれと同じようなものになる。言うまでもなく、データセンターCPUの世界では今でも、大部分はAMDないしはIntelのx86プロセッサーだ。それに対してArm CPUの割合は数%からせいぜい2桁%程度だと考えられている。実際、クルカルニ氏自身も「AWSでも大多数はx86だ」と述べ、近年はGravitonを散々押しているAWSであっても、まだまだ大多数はx86だというのが現実だという(ただ、AWSは具体的な数字は明らかにはしていない)。 では、Gravitonは誰のためにあるのかというと、確かに性能は高いx86プロセッサーだが、弱点は消費電力で電力あたりの性能では、まだまだArmベースのCPUに後れをとっている。そこで、性能はそこそこでいいのでコストを下げたい(EC2のようなインスタンスでは電力もコストに含まれる)顧客がGravitonを選択している、というのが現状なのだ。 クルカルニ氏が言いたいことはTrainium2も同様で、GPUには性能ではかなわないかもしれないが、電力あたりの性能というメリットを生かして低コストで提供することで、より低コストで学習を実現したい、そういう顧客にアピールしたいということだ。 実際、今回のre:Invent 2024の基調講演では、そうした顧客の事例として、Appleの事例が紹介された。Apple マシンラーニング・AI 上級部長 ビノット・デュピン氏は「すでにTrainium2をアーリーアクセスプログラムで利用してきたが、従来の環境に比べて50%の効率が改善されたことが確認できた。こうした環境を利用することで、Appleは顧客に対してさらに優れたユーザー体験を提供することが可能になるだろう」と述べ、すでにTrainium2を活用しており、効率が50%向上する、つまりはコスト削減が実現できたということを明らかにしている。 AppleのようなAIサービスを直接エンドユーザーに提供しているITベンダーにとって、AIにかかるコストは巨大なものだと考えられるだけに、50%もコストを削減できるとしたらその影響は小さくないと言えるだろう。 なお、これまでAWSは、推論用のInferentia、学習用のTrainiumと、2つの製品を別々に展開してきた。Inferentiaの今後の展開に関してAWSは「Inferentiaに関しては、現在もLeonardo.ai、NinjaTechなどのお客さまやAmazon社内のAlexa、RufusなどがInferentiaを活用しており、必要なお客さまに製品を提供し続けていきたい。ロードマップにはまだ明らかにしていないInferentiaの将来世代製品群も存在している」と説明し、今後もInferentiaの開発を継続していく計画であるとしている。 【お詫びと訂正】 ・当初AWSからは、Inferentiaは現行製品で開発は終了し、次世代製品はないという説明がありましたが、同社からその説明は誤りで、正しくは記載の通り、Inferentiaに関しては発表していない将来製品がロードマップにあるという追加の説明がありました。そのため、それに合わせて記事の該当部分を修正いたしました。 今回のre:Invent 2024では、Trainium2の後継製品としてTrainium3が来年投入される計画が明らかにされた。今後はTrainiumがさらに発展していき、学習だけでなく推論に関してもカバーしていくことになる。

クラウド Watch,笠原 一輝